لى فنغ شبكة AI تقنية مراجعة: منذ وقت ليس ببعيد، دكتوراه في علوم الكمبيوتر في جامعة ستانفورد تشن Danqi لتصل إلى 156 أطروحة "العصبية القرائي وبعدها" لتصبح "نماذج المادة الانفجار"، وتسبب في بعض الأحيان ضجة. ونشرت الصحيفة مع نفس درست مع المواد زملاء كريستوفر مانينغ بنغ تشى، NLP اثنين من الماشية الكبيرة من جامعة ستانفورد لاستكشاف أحدث التطورات في آلة القراءة معا في النص. لى فنغ شبكة AI تقنية مراجعة جمعت على النحو التالي.

أنا لا أعرف ما إذا كنت قد بحثت مع متصفح جوجل لديه أي مشاكل (مثل "كم عدد الدول هناك في العالم")؟ المتصفح بإرجاع إجابة محددة سلسلة من الروابط، وليس فقط ما إذا كانوا جعلك أعجب؟ من الواضح، انها جميلة جدا وهذه الميزة هي أيضا عملية جدا، ولكن لا يزال لديها قيود: عند البحث عن شيء مشاكل أكثر تعقيدا (على سبيل المثال، "متى أحتاج لركوب الدراجات الهوائية للاستهلاك السعرات الحرارية تؤكل فقط بيج ماك") جوجل كروم لا يمكن أن تكون جيدة الجواب ردود الفعل - حتى لو كان يمكننا أن نرى الجزء الأمامي من الروابط اثنين والعثور على الإجابات التي تحتاجها.

استشهد الحالة أعلاه البحث Google من المتصفح لنتائج

في اليوم المعلومات انفجار العصر، عندما كنا البشر ضرورة استيعاب المعارف الجديدة كل يوم مع النص (أو أشكال أخرى) تنتج الزائد، والسماح للآلة لمساعدتنا قرأت الكثير من النصوص والإجابة على الأسئلة هي الأهم لفهم مجال اللغة الطبيعية واحدة من أكثر المهام العملية. هذه الآلات حل حجر الزاوية في مهمة قراءة أو السؤال والجواب سوف تضع أهمية لخلق قوية مثل فيلم "آلة الزمن" في نظام AI المكتبية والمعرفة.

في الآونة الأخيرة، مثل ستانفورد Q & A مجموعة البيانات (فرقة، مجموعة البيانات عرض عنوان: الشبكي: //rajpurkar.github.io/SQuAD-explorer/) وTriviaQA (الإدراجات مشاهدة عنوان: HTTP: //nlp.cs.washington.edu/ triviaqa /) وغيرها من البيانات Q على نطاق واسع تسارع بشكل كبير في تطوير لتحقيق هذا الهدف. هذه مجموعات البيانات تسمح للباحثين لدراسة عمق التدريب وعدم وجود نموذج بيانات قوية، والآن الحصول على نتائج جيدة جدا، مثل عدد كبير من الأسئلة بشكل عشوائي يمكن الإجابة من خلال إيجاد الإجابات الصحيحة من صفحة ويكيبيديا الخوارزميات (أوراق ذات الصلة: "القراءة ويكيبيديا للإجابة على الأسئلة المفتوح المجال "، ACL 2017، قراءة عنوان أوراق: الشبكي: //cs.stanford.edu/~danqi/papers/acl2017.pdf)، الأمر الذي يجعل من عمل يد الإنسان لم تعد في حاجة للذهاب الى كل عناء التجهيز .

المنتخب من قبل أكثر من 100،000 عينة من أكثر من 500 التي تم جمعها من تكوين المادة ويكيبيديا. يتم سرد مجموعة البيانات لكل فقرة في المادة في قائمة منفصلة من الأسئلة ونسأل هذه الأسئلة باستخدام عدة كلمات متتالية في فقرة إلى الإجابة (انظر أعلاه سبيل المثال مقالة ويكيبيديا سوبر السلطانية 50 على أساس)، وهذا واسطة، والمعروف أيضا باسم "الأسئلة استخراج من نوع والأجوبة."

ومع ذلك، في حين أن هذه النتائج تبدو جيدة جدا، ولكن هذه مجموعات البيانات أيضا عيوب كبيرة، وهذه النواقص تحد من مواصلة تطوير هذا المجال. في الواقع، أظهرت الباحثون أن هذا النموذج باستخدام هذه مجموعات البيانات ليست في الواقع تدريب لتعلم فهم لغة معقدة للغاية، ولكن تعتمد أساسا على بسيط ارشادي نمط مطابقة (الاستدلال نمط مطابقة).

هذا المثال من أوراق روبن جيا يانغ وبيرسي. يظهر الزيادة في جمل قصيرة، ونموذج لطريقة النموذج مطابقة التعلم للعثور على اسم المدينة، لم يدركوا المسائل والأجوبة.

في هذا المنصب، وسوف نقدم مجموعتين جديدتين من البيانات التي تم جمعها من قبل فريق ستانفورد المعالجة الطبيعية للغة (ستانفورد المجموعة NLP)، ونأمل في مواصلة تعزيز التنمية في مجال آلة قابل للقراءة. على وجه الخصوص، والقصد من ذلك هو أن هذه مجموعات البيانات - إضافة المزيد من المهام في السؤال والجواب "قراءة" و "التفكير" إلى الإجابة على الأسئلة لا يمكن الإجابة قبل وضع مباراة بسيط. واحد هو CoQA، واجهات عن طريق إدخال سياق غنية من محادثة الطبيعية عن جزء من النص من منظور الحوار لحل المشكلة. مجموعة بيانات آخر هو HotpotQA، فإنه لا يقتصر على نطاق الإجابات فقرة، ولكن هذه الطريقة للحصول على الإجابة عن طريق المنطق على وثائق متعددة لمواجهة هذا التحدي، ونحن سوف تظهر هذا النهج في التفاصيل.

CoQA: مجموعة البيانات مسابقة تفاعلية

ما CoQA ذلك؟

تقتصر معظم النظم الحالية للإجابة مسابقة واحدة سؤال (مثل فرقة المثال الموضح أعلاه). على الرغم من أن هذا النوع من السؤال والجواب التفاعل قد تحدث بين الناس، ولكن من خلال المشاركة في سلسلة من القضايا المترابطة التي تنطوي على الحوار والأجوبة للعثور على المعلومات هو وسيلة أكثر شيوعا. CoQA هو Q & A التفاعلية مجموعة البيانات، والذي هو على وجه التحديد للبلدان المتقدمة حول هذا القيد، والهدف من ذلك هو تشجيع تطوير نظام AI التخاطب. يحتوي على بيانات 127،000 لديك أسئلة لم يتم الرد عليها، الحصول على إجابات لهذه الأسئلة والحوار 8000 مجموعة على فقرة من نص من سبعة مختلف المجالات.

كما هو مبين أعلاه، مثال CoQA والحوار على محتوى فقرة يتكون من فقرة من النص (نص في هذا المثال الفقرات التي تم جمعها من المقالات الإخبارية CNN). في هذا الحوار، كل جولة من الحوار تحتوي على سؤال وجواب، ولكل من السؤال الأول بعد السؤال تعتمد على الحوار التي وقعت قبل (كل قضية). فرقة ومختلفة من العديد من مجموعات البيانات الأخرى القائمة، محادثة التاريخ CoQA في الإجابة على العديد من الأسئلة لا غنى عنه. على سبيل المثال، وأنا لا أعرف ما قيل في وقت سابق، وQ2 السؤال الثاني (أين؟) لا يمكن أن يجيب بها. ومن الجدير بالذكر أيضا أن الكيان المركزي الواقع قد تغير في هذه المحادثة، على سبيل المثال، Q4 في "بلده"، Q5 في "كان" و Q6 من "هم" تشير جميعها إلى كيانات مختلفة، كما أنه يجعل فهم هذه القضايا أصبحت أكثر تحديا.

بالإضافة إلى الحاجة إلى إطار الحوار لفهم هذه المشاكل نقطة CoQA الحرجة، كما أن لديها العديد من الميزات الأخرى المثيرة للاهتمام:

-

ومن السمات الهامة هي، CoQA أي جواب للحد من كلمات متتالية في فقرة مثل SQUAD. ونحن نعتقد أن العديد من الأسئلة لا يمكن الإجابة عليها من قبل مجموعة من الكلمات متتالية في الفقرة، التي من شأنها أن تحد من طبيعة الحوار. على سبيل المثال، مثل "كم؟" والسؤال، والجواب يمكن أن يكون إلا "ثلاثة"، على الرغم من أن نص المادة لم مباشرة أن تحدد بوضوح. وفي الوقت نفسه، نأمل أن البيانات المتوفرة لدينا مجموعة لدعم تقييم التلقائي موثوق بها، ويمكن تحقيق درجة عالية من الاتساق مع الجنس البشري. لحل هذه المشكلة، ونحن نطلب من المعلقين أولا التأكيد على مجموعة من النص (من حيث المبدأ الأساسي وراء الجواب، نرى أمثلة على R1، R2، وما إلى ذلك)، ثم قم بتحرير نطاق النص هو الجواب الطبيعي. هذه المبادئ الأساسية يمكن استخدامها في التدريب (ولكن لا يمكن استخدامها في اختبار).

-

معظم مجموعة البيانات QA القائمة يركز على حقل واحد، الأمر الذي يجعل من "تعميم اختبار النموذج القائم" أصبح أمرا صعبا للغاية. ميزة أخرى مهمة هي CoQA من مجموعات البيانات من سبع مناطق مختلفة لجمع من، بما في ذلك قصص الأطفال، والأدب، والمدرسة المتوسطة والثانوية امتحان اللغة الإنجليزية، والأخبار، ويكيبيديا، رديت والعلوم، في حين أن المناطق الماضيين فهو يستخدم لجعل التقييم الخارجي.

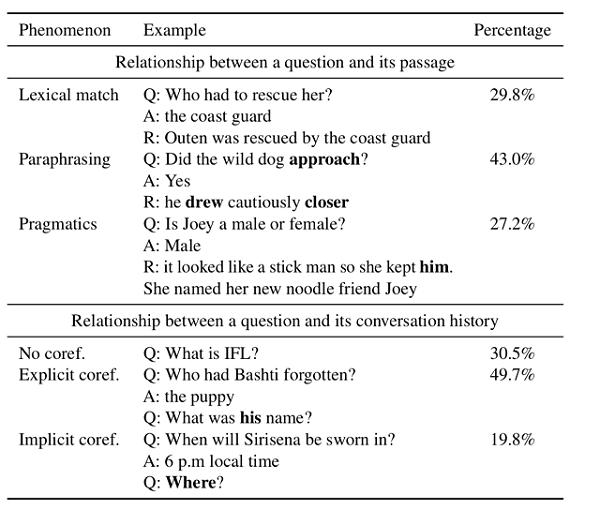

أجرينا تحليل متعمق لمجموعة البيانات. كما هو مبين في الجدول، وجدنا أن هذه البيانات تعيين يظهر ظاهرة لغوية غنية. من هؤلاء، ما يقرب من 27.2 من المشاكل مثل الحاجة إلى الحس السليم والاستدلال العملي مسبقا (المنطق العملي). على سبيل المثال، "استقر بلطف مثل القط"، كما أوضح هذا لا يجيب مباشرة "شخصيته هو صاخبة جدا ذلك؟" سؤال، ولكن أوضح في النظرة بالتزامن قادر على الإجابة على هذا السؤال. بعد فقط 29.8 القضية ببساطة عن طريق مطابقة الكلمات (أي تعيين مباشرة في مشاكل كلمة الفقرة) إلى الجواب.

وبالإضافة إلى ذلك، وجدنا أن فقط 30.5 من إجمالي قضية تشير إلى العلاقة لا تعتمد على التاريخ محادثة مع مستقل، ويمكن الإجابة على الأسئلة. وكانت القضايا المتبقية 49.7 من العدد الكلي تحتوي على مؤشرات واضحة في الاعتبار، مثل "هو"، "هي" و "ذلك"، في حين أن 19.8 المتبقية من المشكلة ( "أين" على سبيل المثال،) والرجوع سرا إلى كيان أو الأحداث.

مقارنة مع مشاكل 2.0 توزيع التشكيلات، وجدنا مشكلة في مسألة من فرقة CoQA في أقصر بكثير (من متوسط عدد الكلمات من 5.5 /10.1)، وهو ما يعكس طبيعة الدورة CoQA هذه البيانات مجموعة. وفي الوقت نفسه، مجموعة البيانات لدينا يوفر أيضا مسألة أكثر ثراء: مع ما يقرب من نصف المشكلة فرقة هو "ما" نوع مختلف من المشكلة، موزعة في جميع أنحاء CoQA مجموعة متنوعة من المشاكل أنواع الأسئلة. عدة قطاعات البادئة "لم"، "كان"، "هو"، "لا"، وتظهر تعليمات أخرى في كثير من الأحيان في CoQA ولكن لم يظهر في تشكيلة الفريق.

آخر التطورات

منذ بدء أغسطس 2018، وكان التحدي CoQA قدرا كبيرا من الاهتمام وتصبح واحدة من أكثر معايير تنافسية في هذا المجال. في نفس الوقت، فوجئنا أنه كان أيضا الكثير من التقدم المحرز منذ الإفراج عنهم، خاصة بعد الإفراج عن مشاركة نوفمبر جوجل بيرت نموذج - هذا النموذج بشكل كبير على تحسين أداء جميع النظم الحالية.

ومعظم النظام مزيج متطور من مايكروسوفت للبحوث آسيا، "بيرت + MMFT + ADA" حققت 87.5 من F1 و 85.3 من الدقة في دقة F1 خارج الإقليم. هذه القيم الدقة ليس فقط بالقرب من الأداء البشري، و 20 نقطة أعلى من نموذج خط الأساس وضعنا منذ ستة أشهر. ونحن نتطلع في المستقبل القريب أن تكون قادرا على رؤية الإفراج عن هذه الأوراق والأنظمة مفتوحة المصدر.

HotpotQA: آلات القراءة متعددة ملف

بالإضافة إلى مواصلة استكشاف السياق تحديدا الفقرة لفترة طويلة من الحوار، ونحن أيضا في كثير من الأحيان تجد أنها بحاجة لقراءة عدد من الوثائق لمعرفة الحقائق حول العالم.

على سبيل المثال، شخص ما قد تريد أن تعرف، "تأسست الدولة ياهو! ما هي؟" أو "جامعة ستانفورد وجامعة كارنيجي ميلون الباحثين علوم الكمبيوتر التي المدرسة أكثر من ذلك؟" أو أسئلة بسيطة مثل "لا يحرق العملاقة السعرات الحرارية سنويا ولست بحاجة لقضاء الكثير من الوقت؟ "

تغطي شبكة عددا كبيرا من الإجابات على مثل هذه المشاكل، ولكن ليس دائما في شكل متاحة بسهولة، ولا حتى الإجابة في مكان واحد. على سبيل المثال، إذا كان لنا بمثابة الجواب ويكيبيديا على السؤال الأول (تأسست ياهو التي الدولة؟) مصدر المعرفة، فإننا لن بدء البحث لياهو! لم الصفحة أو لها المؤسس المشارك جيري يانغ والمعلومات الشخصية لديفيد فيلو لم يذكر معلومات حول هذا الموضوع (على الأقل في وقت كتابة هذه السطور، والمعلومات الشخصية من اثنين لا يذكر ذلك) الخلط.

للإجابة على هذا السؤال، يحتاج المرء إلى المواد الاستعراض جهد ويكيبيديا المقال، حتى يروا المقالة التالية بعنوان "ياهو التاريخ"، والمقالة:

يمكن للمرء أن يقول نتمكن من الإجابة على هذا السؤال من خلال المنطق الخطوات التالية:

-

ونلاحظ أن الجملة الأولى من هذه المادة تنص على أن "ياهو! تأسست في جامعة ستانفورد."

-

ثم، يمكننا أن ننظر ل "جامعة ستانفورد" في ويكيبيديا (في هذه الحالة، نحن بحاجة فقط إلى الضغط على الرابط) والعثور على عنوان وتقع جامعة ستانفورد.

-

جامعة ستانفورد الصفحة إظهار أنه يقع في "كاليفورنيا".

-

وأخيرا، يمكننا الجمع بين هاتين الحقيقتين للوصول إلى الإجابة على السؤال الأول: "تأسست ياهو في كاليفورنيا!".

لاحظ أنه، للإجابة على هذا السؤال، هناك نوعان من المهارات الضرورية: (1) كشف قادرة على القيام ببعض الأعمال، وذلك ما يمكن الإجابة على أسئلتنا أو المستندات المؤيدة لاستخدامها لمعرفة الحقائق، و (2) القدرة على الحصول على الجواب النهائي باستخدام متعددة دعم المنطق البيانات.

بالنسبة لنظام آلة القراءة، وهذه هي كل ما يحتاجونه للوصول من أجل تقديم مساعدة فعالة قدرتنا على استيعاب المعلومات والمعرفة من المحيط نموا في شكل النص الهامة. للأسف، ويرجع ذلك إلى مجموعة موجودة من بيانات كان دائما تركز على البحث عن الإجابات في وثيقة واحدة، ولا يمكن التعامل مع هذا التحدي، لذلك دعونا جهود في هذا الصدد (نظام القراءة آلة حصلت عليها مجموعات البيانات المذكورة أعلاه جمعت HotpotQA المهارات اثنين).

ما هو HotpotQA؟

HotpotQA Q هو عبارة عن مجموعة كبيرة من البيانات، التي تضم حوالي 113،000 مجموعة Q تتضمن تلك الميزات التي ذكرناها أعلاه. وبعبارة أخرى، فإن هذه المشاكل تتطلب نظام قادر على فحص عدد كبير من الوثائق والنصوص للعثور على المعلومات والأجوبة على توليد واستخدام متعددة تدعم حقيقة أن تعليلها للعثور على الجواب النهائي الإجابة (انظر المثال أدناه).

الأسئلة عينة من HotpotQA

هذه الأسئلة والأجوبة هي من كامل ويكيبيديا التي تم جمعها من، وتغطي مجموعة متنوعة من الموضوعات من العلوم والفلك والجغرافيا والترفيه، والرياضة والسوابق القانونية.

للإجابة على هذه الأسئلة، ونحن بحاجة إلى استخدام مجموعة متنوعة من تحدي المنطق. على سبيل المثال، ياهو! الحالات، يحتاج الباحثون إلى استنتاج كيان ياهو والإجابة على الأسئلة الأساسية ل "العلاقة" - العلاقة بين البلدين، "جامعة ستانفورد"، ثم استخدم حقيقة أن "ستانفورد في ولاية كاليفورنيا." للوصول إلى الحل النهائي. جلي، وسلسلة كاملة من التفكير على النحو التالي:

هنا، ونحن سوف "جامعة ستانفورد" كيان يسمى الجسر (جسر كيان) السياق، لأنه كان بمثابة جسر بين "كاليفورنيا" في كيان يعرف ياهو! الأجوبة والأهداف. لاحظنا أن العديد من القضايا مهتما نحن في حقيقة أن إلى حد ما ترتبط مثل هذا الكيان سد.

على سبيل المثال، ونظرا للمشكلة التالية: اللاعبين الحصول على لقاح التهاب السحايا في عام 2015 لعبة رأس الماس الكلاسيكية إضافة إلى الفريق الذي؟

في هذه المشكلة، يمكننا أولا أن نسأل أنفسنا: من هو أفضل لاعب في عام 2015 لاعبين لعبة الماس رئيس كلاسيكي؟ ثم حدد موقع لاعب يضيف حاليا فريق ما. في هذه المشكلة، MVP لاعب (بودي هيلد) بمثابة دليل نجد الصحيح الكيان الجواب سد. وياهو! CBR بطريقة مختلفة قليلا، بودي هيلد هنا هو جزء من الجواب على السؤال الأول، ومع ذلك، "جامعة ستانفورد" ليس جزءا من الحل.

أستطيع أن أفكر بسهولة من بعض "كيان سد هذا هو الجواب" أسئلة مثيرة للاهتمام، مثل: إد هاريس دور البطولة في الفيلم الذي يستند إلى رواية اطلاق النار الفرنسي؟ (والجواب هو "قطار بلد الثلوج".)

من الواضح، وسوف تكون قادرة على محاولة الإجابة عن كل مجموعة مثيرة للاهتمام من الحقائق يأتي من ويكيبيديا عن طريق المنطق الجسور أكثر، وهذه القضايا لا يجوز تغطيتها بالكامل. في HotpotQA، نقترح نوع جديد من مشكلة لتمثيل مهارات التفكير أكثر تنوعا والقدرة على فهم اللغة، وهذا هو: مقارنة نوع المشاكل (مسألة المقارنة).

أمام ذكرنا مشكلة نوع المقارنة: المزيد من جامعة ستانفورد وجامعة كارنيجي ميلون الباحثين علوم الكمبيوتر التي المدرسة؟

من أجل الإجابة بنجاح على هذه الأسئلة، والإجابة على النظام لا يحتاج فقط لتكون قادرة على الحصول على الدعم من الحقائق ذات الصلة (دعم الحقائق في هذه الحالة هو أن أرقام كل من جامعة ستانفورد وجامعة كارنيجي ميلون الباحثين في العلوم الكمبيوتر لديها)، ولكن أيضا وسيلة مفيدة لكلا مقارنة للحصول على الجواب النهائي. ومع ذلك، وفقا لتحليلنا هذه البينات، أسئلة وأجوبة عن النظام الحالي، بطريقة ذات معنى للمقارنة بين الحقائق الداعمة ذات الصلة صعبة للغاية، لأنها قد تنطوي على المقارنة العددية، وهي المرة المقارنة، العد حتى خوارزمية مقارنة بسيطة.

ومع ذلك، والعثور على الحقائق الداعمة ذات الصلة ليست سهلة، أو ربما حتى أكثر تحديا. على الرغم من العثور على العام نوع الحقائق المقارنة ذات الصلة من المشكلة هو سهل نسبيا، ولكن لسد القضايا الجوهرية، وهذا مهم جدا.

نحن نستخدم الطريقة التقليدية استرجاع المعلومات (IR) للتجربة، وبالنظر إلى القضية باعتبارها الاستعلام الكلمة الاستعلام، وطريقة لجميع المواد ويكيبيديا فرز (من الأكثر إلى الأقل من المقالات ذات الصلة المواد ذات الصلة). نتائج مرحلة وجدنا أنه، في المتوسط، في الإجابة الصحيحة على سؤال مرحلتين الأساسية (التي نسميها "فترة ذهبية") بخلاف أول 10 نتائج الأنواع فقط حوالي 1.1 الإجابات الصحيحة. الشكل IR النوع من الذهب المرحلة المقبلة، مرحلة مرتبة أعلى وأسفل ترتيب عرض مسرحي لتوزيع الذيل طويل.

وبشكل أكثر تحديدا، يمكنك العثور على أعلى ترتيب أكثر من 80 في نتائج IR الفقرة في أعلى 10، ولكن خفض الفقرة الترتيب يتبين أنهم ليسوا 30. حسبنا أنه إذا وجد رجل اثنين "الفقرة داعمة الذهبية" قراءة بسذاجة قبل جميع المقالات مرتبة أعلى، ثم أجاب على سؤال تحتاج إلى قراءة في المتوسط نحو 600 في المادة - حتى بعد قراءة هذه بعد المادة، الخوارزمية لا يزال لا يمكن أن أقول بشكل موثوق ما إذا كنا قد وجدت حقا "الفقرة داعمة الذهبية" اثنين!

عندما يكون الجهاز يقوم بقراءة مشاكل في الممارسة العملية لاستخدام عدة خطوة الاستدلال، ونحن بحاجة الى طرق جديدة لحل هذه المشاكل، لأن التقدم في هذا الاتجاه من شأنها أن تعزز بشكل كبير في تطوير نظام الحصول على المعلومات أكثر فعالية.

للتفسير نحو تطوير نظام الرد

نظام الرد سؤال جيد، انها ميزة مهمة ومرغوبة آخر هو تفسيرها. في الواقع، لا يمكن ببساطة أن ترسل الحل الوحيد لمساعدة التحقق من إجاباتهم لها لشرح أو توضيح نظام الرد لا طائل منه في الأساس، لأن معظم الوقت حتى لو تظهر الإجابات أن يكون صحيحا، ويمكن للمستخدم لا يمكن الوثوق النظام يعطي الجواب. للأسف، وهذا أيضا سؤال وجواب العديد من معظم مشاكل النظام المتقدمة.

لهذا السبب، في وقت HotpotQA جمع البيانات، وطلبنا أيضا من المعلقين لدينا تفاصيل الأحكام الصادرة بحقهم لدعم التوصل إلى الحل النهائي، وهذه الأحكام كجزء من مجموعة البيانات للإفراج عنه.

في المثال التالي من مجموعة البيانات الفعلية، الجملة الخضراء باعتبارها حقائق تدعم تدعم الجواب (على الرغم من أن في هذه الحالة يتطلب المنطق من خلال عدد من الخطوات). للحصول على مثال رؤية أكثر (أقل كثافة) من الحقائق المؤيدة، يمكننا مستكشف البيانات HotpotQA (//hotpotqa.github.io/explorer.html عنوان :: HTTPS).

في تجاربنا، شهدنا تدعم هذه الحقائق لا يمكن إلا الناس إلى أكثر سهولة اكتشاف الإجابة إجابات نظام معين، ولكن أيضا من خلال تقديم نموذج إشراف أقوى (Q & A مجموعة البيانات في وقت سابق في هذا الاتجاه عدم وجود رقابة)، لتحسين النظام نفسه لإيجاد أكثر دقة الأداء المثالي الجواب.

الأفكار النهائية

كما المعرفة الإنسانية إلى السجلات المكتوبة من الأغنياء على نحو متزايد، ودائما هو رقمية أكثر وأكثر إنسانية المعرفة، فإننا نعتقد أن هناك قيمة كبيرة لهذا الشيء: هذه المعرفة وتمكين المنطق الآلي والقراءة والإجابة على أسئلتنا النظام جنبا إلى جنب، مع الحفاظ على هذه النظم يمكن الإجابة التفسيري. والسؤال المطروح الآن الإجابة النظام في كثير من الأحيان فقط من خلال النظر في عدد كبير من الفقرات والجمل، ثم استخدام "الصندوق الاسود" (معظمهم لكلمة نمط مطابقة) للإجابة على هذا السؤال، والآن يتم تطويره إلى ما بعد الوقت نظام الرد بهم.

تحقيقا لهذه الغاية، نظرت CoQA مجموعة من يظهر الحوار الطبيعي في سياق أسهم معينة، وكذلك متطلبات لاستنتاج محادثة أكثر من واحد مع تحدي المشاكل، ومن ناحية أخرى، يركز على HotpotQA متعددة ثيقة المنطق، وتشجيع المجتمع البحوث لتطوير طرق جديدة للحصول على دعم من جسم كبير من المعلومات.

ونحن نعتقد أن هذه مجموعتي البيانات تدفع التطورات الهامة نظام الرد عليها، ونحن نتطلع إلى هذه الأنظمة سوف تجلب أفكارا جديدة في مجتمع البحوث بأكمله.

فيا: الشبكي: //ai.stanford.edu/blog/beyond_local_pattern_matching/ شبكة لى فنغ