هذا المقال هو عبارة عن تجميع للAI Yanxishe بلوق التكنولوجيا، والتاريخ العنوان الأصلي من التلافيف كتل كود بسيط، من تأليف بول لويس إثبات. الترجمة | تصحيح التجارب المطبعية منغ | مراجعة Lamaric | Lamaric

سوف أحاول أن أقرأ بانتظام التعلم الآلي والأوراق المتعلقة الذكاء الاصطناعي. هذه هي الطريقة الوحيدة لمتابعة آخر التطورات يمكن أن يستمر. كعالم كمبيوتر، وكثيرا ما واجهت جدار عند قراءة رموز الرياضيات لوصف النص العلمي أو الصيغة. أجد أنه من الأسهل بكثير لفهم في القانون العام. لذلك، في هذه المقالة أود أن يرشدك إلى تحقيق مهمة جديدة العمارة كتلة الإلتواء الذي اختاره Keras.

وعندما يتم تنفيذ مراجعة الهيكل شعبية على جيثب، وسوف يفاجأ في مقدار ما سوف تحتوي على التعليمات البرمجية. هذا هو جيد يحتوي على عدد كاف من التعليقات ومعلمات إضافية لتعزيز نموذج الممارسة، ولكن في الوقت نفسه أنها سوف يصرف انتباه جوهر العمارة. من أجل تبسيط واختصار رمز، وسوف تستخدم بعض الوظائف الاسم المستعار:

لقد وجدت أنه عند حذف رمز قالب أكثر قابلية للقراءة. بالطبع، هذا إلا إذا كنت أفهم اختصار بعد فعالية، دعونا تبدأ المفضل

كتلة عنق الزجاجة

يعتمد عدد المعلمات على التفاف نواة حجم طبقة التفاف، وعدد من تصفية إدخال وإخراج التصفية. سوف أوسع الشبكة أو 3X3 التفاف دفع سعر أعلى.

الفكرة وراء كتلة هو عنق الزجاجة للحد من عدد من القنوات بتكلفة صغيرة من ص نسبة تحديد والإلتواء 1X1 للالتفاف 3X3 لاحق مع عدد أقل من المعلمات. وأخيرا، فإننا مرة أخرى استخدام شبكة واسعة 1X1 الإلتواء.

بداية الوحدة

قدم بداية استخدام مواز من وحدات مختلفة والنتيجة الإجمالية لتشغيل الفكر. ذلك أن الشبكة يمكن أن تتعلم أنواع مختلفة من المرشحات.

هنا نستخدم حجم التفاف نواة التفاف طبقة 3 و 5 طبقة وMaxPooling مجتمعة. يظهر هذا الرمز وحدة بداية تنفيذ الأصلي. ويعتقد أن التنفيذ الفعلي لدمجها مع عنق الزجاجة المذكورة أعلاه، مما يجعله أكثر قليلا معقدة.

كتلة المتبقية

ResNet هو باحث من إطلاق العمارة مايكروسوفت، التي تسمح للشبكة العصبية لديها طبقات يريدون الحصول عليها، في حين لا تزال قادرة على تحسين دقة هذا النموذج. الآن قد تضطر إلى تعتاد على ذلك، ولكن قبل ResNet ليس هو الحال.

والفكرة هي أن تضيف إلى تفعيل الأولي للناتج كتلة الإلتواء. وبالتالي فإن الشبكة يمكن استخدامها لتحديد عدد من الناتج التفاف جديد من خلال عملية التعلم. هل لاحظ أن تتلخص الخرج التأسيس في سلسلة، وحدة المتبقية.

كتلة ResNeXt

وبناء على اسمها يمكنك تخمين ResNeXt اتصال وثيق مع ResNet. على المدى سحابة من القاعدة إلى بعد آخر، مثل عرض (رقم القناة) وعمق (عدد المستويات).

يلاحظ قاعدة (مع أصل) الآن أن عدد المسارات في نفس الوقت في وحدة. هذا يبدو وكأنه كتلة بداية تحدث أربع عمليات في نفس الوقت. ومع ذلك، بدلا من استخدام مواز من أنواع مختلفة من العمليات، الجذر-4 العملية بسيطة لاستخدام نفس أربع مرات.

إذا لم يفعلوا الشيء نفسه لماذا يجب علينا وضعها جنبا إلى جنب؟ سؤال جيد. ويشار إلى هذا المفهوم أيضا باسم حزم الإلتواء ويمكن أن ترجع إلى أوراق AlexNet الأصلية. وعلى الرغم من انه كان يستخدم بشكل رئيسي لكسر عملية التدريب أكثر GPU، في حين ResNeXt ثم استخدامها لزيادة كفاءة المعلمات.

والفكرة هي لنقل كافة قنوات الإدخال إلى عدة مجموعات. والإلتواء فقط ولن تؤثر على جميع الفئات القناة في مجموعة القنوات الخاصة. تصفيفة الشعر كل مجموعة سوف تتعلم أنواع مختلفة من الميزات، مع زيادة كفاءة الوزن.

تخيل كتلة عنق الزجاجة باستخدام نسبة ضغط الأولى سيتم تخفيض بنسبة 4256-64 قنوات الإدخال، ومن ثم استعادتها إلى 256 قنوات كإخراج. إذا كنا نريد أن نقدم 32 قاعدة 2 ونسبة الضغط، وسوف نستخدم طبقة 32 مواز التفاف 1X1، وإخراج كل قناة 4 (256 / (32 * 2)) أ. ثم نستخدم طبقة الإلتواء 32 ديها أربع قنوات إخراج 3X3، 1X1 جاء بنسبة 32 طبقات، كل واحد 256 قنوات الانتاج. ويتألف الخطوة الأخيرة إضافة مسار مواز 32، بحيث بالإضافة إلى المدخلات الأولية متصلة المتبقية أمامنا كما توفر الإخراج واحدة.

اليسار: الكتل ResNet اليمين: تعقيد المعلمة من كتل متطابقة إلى حد كبير ResNeXt

هناك الكثير الهضم. FIG باستخدام فهم بديهية للكيفية التي يمكن أن تعمل، لا يجوز نسخ رمز مباشرة باستخدامها Keras بناء شبكة صغيرة. أستطيع أن أصف مدى تعقيد هذه السطور البسيطة 9 من التعليمات البرمجية لخص، ليس هو عظيم؟

بالمناسبة، إذا كان عدد من القنوات من نفس القاعدة، ونحن سوف تحصل على شيء يسمى عمق التفاف فصل. منذ إدخال العمارة Xception منذ ذلك الحين، وقد استخدم على نطاق واسع.

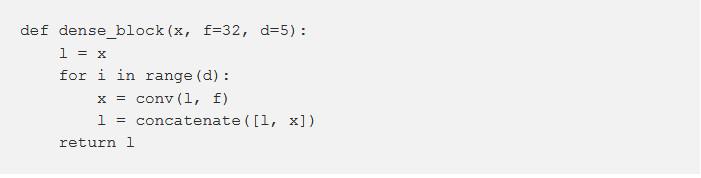

كتلة كثيفة

كتلة كثيفة هو نسخة متطرفة من كتلة المتبقية، حيث خرج كل التفاف جميع طبقات قبل هذه الكتلة ستكون طبقة الإلتواء. أولا، لدينا لتفعيل قائمة المدخلات، ثم ندخل حلقة، حلقات من خلال عمق الكتلة. من أجل تعيين ميزة الإدخال التكرار أكثر اللاحقة. وسوف يستمر هذا البرنامج حتى الوصول إلى العمق المطلوب.

وعلى الرغم من أن تكون قادرة على مثل DenseNet مثل بنية جيدة يأخذ أشهر من البحث، ولكن لبنات البناء الفعلي هو بهذه البساطة رائعة.

ضغط، والإثارة كتلة

سينيت في وقت قصير هو هندسة معمارية بارزة جدا من ImageNet. وهو يعتمد على ResNext، ولكن أيضا التركيز على قنوات شبكة المعلومات عن طريق النمذجة القناة. في طبقة التلافيف التقليدية لكل قناة لديه نفس الأوزان نقطة المنتج في عملية الجمع.

كتلة والإثارة Squeeze-

قدم سينيت وحدة بسيطة جدا التي يمكن أن تضاف إلى أي بنية القائمة. يخلق الشبكة العصبية الصغيرة يمكن أن يتعلم وزن كل الأوزان مرشح على أساس المدخلات. يمكنك أن ترى أنه في حد ذاته ليس كتلة والالتواء، ولكن لأنه يمكن أن تضاف إلى أي كتلة الإلتواء ولكن أيضا يمكن تحسين الأداء، لذلك أريد أن إضافته إلى بنية المزيج.

يتم ضغط كل قناة في قيمة واحدة وإدخالها في الشبكة العصبية من طبقتين. قناة التوزيع، سيتم المرجحة هذه الشبكة على أساس أهمية هذه القنوات، وأخيرا الأوزان مضروبا في التفاف وتفعيل.

قدم سينيت أحمال الحسابي صغير، ولكن أي حجم ممكن لتحسين نموذج الآلة. في رأيي، لم تمنح هذه الكتلة الاهتمام الواجب.

خلية مستوى NASNET

هذا هو المكان الذي تبدأ الأمور القبيح. نحن نترك الناس الفضائي، اقتراح بسيط وقرارات التصميم الفعالة وهندسة الشبكات العصبية في العالم من تصميم خوارزمية. NASNET لا يصدق من حيث التصميم، إلا أن العمارة الفعلية معقدة نسبيا. ونحن نعلم أن في ImageNet أدائه جيد جدا.

من جهة، يحدد المؤلف فضاء البحث لأنواع مختلفة من الالتواء وبرك من طبقات، كل طبقة لديها مجموعة مختلفة من الاحتمالات. ويعرف أيضا كيف يتم ترتيب هذه الطبقات في موازاة ذلك، وكيف أن النظام أو إضافة مجموعة من هذه الطبقات. بالتأكيد هذا التعريف، قاموا ببناء تعزيز التعلم القائم على المتكررة خوارزمية الشبكة العصبية (RL)، إذا كان أداء جيدة تصميم خاص على مجموعة البيانات CIFAR-10، سوف يكافأ عليه.

العمارة مما أدى ليست فقط مرة أخرى على CIFAR 10 أداء جيدا، كما أنها ImageNet الحصول على نتائج باهرة. NASNET الخلايا القياسية وحدات خفض، وتكرار بعضها البعض.

هذه هي الطريقة التي تستخدم وحدة قياسية في التعليمات البرمجية Keras. بالإضافة إلى مجموعة من السهل جدا استخدام وتعيين طبقة ليست شيئا جديدا.

اقلب كتلة المتبقية

......

تريد مواصلة القراءة، يرجى الانتقال إلى مجتمعنا AI Yanxishe: الشبكي: //club.leiphone.com/page/TextTranslation/614

المزيد من المحتوى المثير لجعل AI Yanxishe. لى فنغ لى فنغ صافي صافي

مختلف المجالات بما في ذلك رؤية الكمبيوتر، ودلالات الكلام، سلسلة كتلة، الطيار الآلي، واستخراج البيانات، التحكم الذكي، لغات البرمجة وغيرها تحديثها يوميا.

لى فنغ شبكة فنغ لي