الناس تفاؤلا يريد في المستقبل تكون قادرة على استكمال آلة تعلم قيادة السيارة، واستقبال المكالمات، والتعيينات، والرد البريد الإلكتروني لهذه البشرية لإكمال المهمة. ولكن الواقع هو في كثير من الأحيان نحيف جدا. تعلم الآلة الحديثة يمكن أن تحل المشكلة بشكل فعال لا يزال نطاق ضيق جدا، على سبيل المثال، توصية البرنامج على نيتفليكس أو الحوسبة ETA.

ومع ذلك، عندما الافراج OpenAI GPT-2، فقد تم تخفيض الفجوة بين الآلات والبشر.

ببساطة عن طريق يدل على حجم النموذج، OpenAI وضع نموذج لغة مشتركة، يمكن أن يكون أكثر سلاسة التعامل مع المهام الإنسانية من خلال هذا الأخير (على الرغم من أن في بعض الأحيان ناقصة):

المصدر: OpenAI

GPT-2 يبدو ليس من قبيل الصدفة، وكان أفرج عنه بعد فترة وجيزة، صدر Salesforce نموذج لغة 1600000000 المعلمة CTRL. NVIDIA شيدت ميجاترون، محول المعلمات نموذجا لل8000000000. في الآونة الأخيرة، أصدرت جوجل معظم نموذج متقدم للدورة مينا لديها 2.6 مليار المعلمة.

حتى في مجال الرؤية الحاسوبية لتحقيق أداء أفضل في كثير من الأحيان يتطلب نموذج أكبر. في صيف عام 2018، في GPT-2 صدر لأول مرة قبل بضعة أشهر، أصدرت جوجل NASNET، وهذا هو الرقم القياسي للنموذج تصنيف الصور، التي لديها 88900000 المعلمات، تكون قادرة على التعرف على الكائنات الصورة السائدة في صورة من أي شيء آخر نموذج تصنيف أكبر:

المصدر: سيك-هو تسانغ

الاتجاه واضح. من أجل تحقيق مدفوعة مستقبل أفضل رؤية آلة التعلم، وهذه "السوبر موديل" سوف تنمو. ولكن السؤال الآن هو:

فهي كبيرة جدا، أي وسيلة لاستخدامها في الإنتاج.

ما هي التحديات التي واجهت نموذج السوبر؟

تواصل نموذج لتوسيع ونشر لهم في الإنتاج وأصبح من الصعب على نحو متزايد. مع GPT-2 كمثال:

-

GPT-2 هو أكبر من 5 GB . نموذج جزءا لا يتجزأ محليا في برنامج التطبيق لم يتم تحديد الأجهزة النقالة.

-

GPT-2 يحتاج إلى حساب . لخدمة التنبؤ واحد، GPT-2 قد شغل عدة دقائق في استخدام وحدة المعالجة المركزية بنسبة 100. حتى مع GPU، التنبؤ لا يزال يأخذ بضع ثوان. ويقارن هذا مع تطبيق ويب يمكن استخدام وحدة المعالجة المركزية التي تخدم مئات المستخدمين المتزامنين.

-

العظمى GPT-2 الطلب الذاكرة . بالإضافة إلى مساحة القرص كبير واحتياجات الحوسبة، GPT-2 يتطلب أيضا الكثير من الذاكرة من أجل ضمان التشغيل السلس.

وبعبارة أخرى، GPT-2 على نطاق واسع، كثيفة الاستخدام للموارد وبطيئة. لوضعها في الإنتاج هو التحدي، وتوسيع نطاق هو أكثر صعوبة.

هذه المشاكل ليست فريدة من نوعها GPT-2، التي هي مشتركة بين جميع هو نموذج عظمى، وسوف تصبح فقط أكبر ليصبح نموذج أسوأ من ذلك. لحسن الحظ، وآلة التعلم البيئي في عدد من المشاريع يتم القضاء على هذه العقبة.

كيف يمكننا حل مشكلة السوبر موديل

على الرغم من أن من السابق لأوانه حل المشكلة تماما، ولكن الاتجاه العام من طراز سوبر لإيجاد حل لمشكلة ثلاث نقاط:

1. نموذج أصغر

إذا أصبح نموذج كبير جدا، والطريقة الأكثر مباشرة هو ضغط عليها.

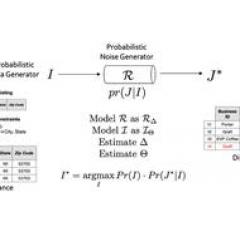

طريق واحد هو طريق المعرفة التقطير. على مستوى عال جدا، ويمكن القول أن نموذج صغير (الطلاب) يمكن أن تحاكي أداء نماذج كبيرة (الآباء والأمهات) من خلال التعلم.

وبعبارة أخرى، وتدريب GPT-240 GB الحاجة لإدخال النص، وهو ما يعادل ملف نصي ما يقرب من 27118520. ومع ذلك، وتدريب نموذج GPT-2 مبسطة، ما عليك سوى أن تقدم له المدخلات والمخرجات من GPT-2.

المكتبة المحولات NLP الشهيرة وراء إنشاء هذه الشركة HuggingFace DistilGPT2. وعلى الرغم من بعض نقاط DistilGPT2 أقل من جودة الإشارة الكامل نموذج رقم GPT-2، لكنه أكثر من نموذج كامل GPT-233 أصغر، أسرع مرتين.

السرعة هي ضعف صفقة كبيرة. للحصول على سيارة القيادة الآلية، السيارات بشكل آمن وتعطل هما شيئان مختلفان. عن وكيل التخاطب، هو الفرق بين الطبيعي والحوار مع دعوات روبوت مزعج.

في الواقع، يمكنك أداء DistilGPT2 وGPT-2 وHuggingFace مقارنة مع تفاعل كتابة المحولات المحرر:

المصدر: الكتابة مع المحولات

2. نشر نموذج إلى سحابة

ولكن، حتى بعد التقطير، ونموذج لا يزال كبيرا جدا. نموذج يتجاوز 25 GB (NVIDIA ميجاترون هو 5.6 مرة GPT-2) هو، أي بانخفاض 33 لا يزال كبيرا جدا.

في هذا النطاق، وكنا تستهلك المعدات ولدت ML-محتوى - لدينا هاتف، تلفزيون، وحتى أجهزة الكمبيوتر لدينا - لا يتم استضافة هذه النماذج، فإنها لا تناسب.

حل واحد هو نشر نموذج سحابة باعتباره خدمات الدقيقة، يمكن الاستعلام معداتنا حسب الحاجة. وهذا ما يسمى في الوقت الحقيقي المنطق، هو الطريقة القياسية لطراز نشر على نطاق واسع في الإنتاج.

ومع ذلك، في نشر سحابة لديها مشاكلها الخاصة، وخاصة حجم المشكلة.

على سبيل المثال، دعونا ننظر AI الأبراج، والتي تحظى بشعبية لعبة مغامرة النص، استنادا إلى GPT-2:

نظرا لحجم والحسابية متطلبات GPT-2، يمكن AI الأبراج تخدم سوى اثنين من المستخدمين من نشر نموذج واحد. مع زيادة في حركة المرور، تحتاج AI الأبراج لرفع مستوى تلقائيا.

تمديد GPT-2 نشر هو صعب جدا. فإنه يتطلب منك:

-

تأكد من أن كل نشر هو نفسه. على سبيل المثال، باستخدام نموذج عامل الميناء بالحاويات، واستخدام ترتيب الحاويات Kubernetes.

-

التلقائي نشر على نطاق والخروج. على سبيل المثال، عن طريق ترتيب مثيل قشارة مزود سحابة التلقائي الدورية صعودا وهبوطا تلقائيا وفقا لحركة المرور.

-

الموارد تحسين. يعني العثور على أدنى تكلفة وتخصيص الموارد نوع المثال دون التضحية بالأداء.

إذا الحق في القيام به، وسوف يحصل على مبلغ مالي كبير من فاتورة سحابة - نشر 200 حالات g4dn.2xlarge تكلفة 150.40 $ للساعة الواحدة، أو سوف تجد نفسك في تعطل API خدمة التنبؤ في كثير من الأحيان.

وبعبارة أخرى، على نماذج كبيرة لخدمتكم، تحتاج حاليا لديها معرفة كبيرة devops، ومعظم البيانات لا يمكن إكمال العمل من العلماء والمهندسين البنية التحتية.

لحسن الحظ، بعض المشاريع التي تعمل على القضاء على هذه عنق الزجاجة.

قشرة مشروع مفتوح المصدر مثل هذه مشاريع البنية التحتية --AI الأبراج وراءها، كما هو مطلوب على نطاق واسع الآلي نموذج النشر devops أدوات العمل، وقد حظيت باهتمام واسع النطاق:

المصدر: اللحاء جيثب

3. أجهزة الخدمة نموذج تسريع

الفئة الأخيرة لجعل الأمر أكثر سهولة لخدمة نموذج كبير من الأساليب والنماذج ليس لديها أي علاقة. بدلا من ذلك، أنها تتعلق تحسين الأجهزة.

نموذج كبير أداء أفضل على أجهزة مختلفة. في الواقع، وكما قلت من قبل، لماذا GPU مهم لنموذج الخدمة؟ وذلك لأن فقط على GPU يمكن أن تكون منخفضة الكمون يكفي للحصول على خدمات GPT-2، مثل التصحيح التلقائي:

ضرب معظم الناس 40 كلمة في الدقيقة، ويبلغ متوسط الكلمة الإنجليزية عن خمسة أحرف، وبالتالي فإن الشخص العادي يدخل 200 حرفا في الدقيقة الواحدة، أو أدخل 3.33 حرفا في الثانية الواحدة. الذهاب خطوة أبعد، يعني ذلك أن الشخص العادي بين كل مرة إدخال حرف ما يقرب من 300 ميلي ثانية.

إذا كنت تعمل على وحدة المعالجة المركزية، وتحتل 925 ميلي ثانية في الطلب، فإن Gmail معدل تخليق الذكي الخاص بك إبطاء. عندما كنت تتعامل مع شخصية المستخدم، ثلاثة منهم تعود الشخصيات الرائدة - إذا كان المدخل هو آلة كاتبة سريعة، بل وأكثر في المستقبل.

ومع ذلك، مع مساعدة من GPU، سرعة معالجة الخاص بك هو متقدما بفارق كبير منهم. عندما يحتل كل طلب 199 ميلي ثانية، سوف تكون قادرة على التنبؤ بقية الرسالة مع وقت الفراغ ما يقرب من 100 مللي ثانية، وهو أمر مفيد جدا عندما برامج التصفح الخاصة بهم لا تزال بحاجة إلى تقديم التوقعات الخاصة بك.

ومع ذلك، كنموذج ينمو، نحن بحاجة إلى المزيد من قوة المعالجة.

الحل لهذه المشكلة تشمل بناء الأجهزة الجديدة. على سبيل المثال، أصدرت جوجل TPU، والتي تكرس نفسها إلى واجهات TensorFlow تصميم أسيك. أحدث TPU جوجل اندلعت مؤخرا مؤشر قابلية نموذج الخدمة وسجلات الأداء. الولايات المتحدة أمازون السحابية (AWS) الذي صدر مؤخرا المهنية الخاصة رقاقة تعليلها.

ويشمل أعمال أخرى تسارع وتعظيم الاستفادة من الأجهزة الموجودة. على سبيل المثال، صدر NVIDIA TensorRT، وهذا هو خدمة لتحسين المنطق استخدام NVIDIA GPU من SDK. وقد سجلت NVIDIA باستخدام TensorRT على أداء GPU، هو أكثر من المنطق زيادة CPU-فقط بنسبة 40 مرات.

وسوف تصبح آلة التعلم شائعة

في نواح كثيرة، وآلة التعلم لا تزال مثل الغرب المتوحش مثل الولايات المتحدة.

GPT-2 مثل سوبر نموذج فقط بدأت في الظهور، بالإضافة إلى الشركات الكبيرة، والتعلم الآلي وتصبح أكثر قبولا من قبل المهندسين، يبدو العمارة النموذج ليكون انطلاقة جديدة في متناول اليد.

ومع ذلك، شهدنا ظهور تعلم الآلة تقريبا في كل مناطق عمودية، من وسائل الإعلام لالمصرفية لتجارة التجزئة. ليس من المستغرب، في المستقبل القريب، لا يكاد منتج لن ينطوي على التعلم الآلي.

مع آلة التعلم لتصبح جزءا أساسيا من البرنامج، وسوف تصبح تحديات نشر النماذج على نطاق واسع في إنتاج أيضا شائعة.

عن طريق: الشبكي: //towardsdatascience.com/too-big-to-deploy-how-gpt-2-is-breaking-production-63ab29f0897c

شبكة شبكة شبكة لى فنغ لى فنغ لى فنغ