لى فنغ شبكة AI تقنية مراجعة من قبل: اذكر RNN، التي يرجح أن نفكر تحقيق هو LSTM + الاهتمام. LSTM كأنهم بنيان شبكة الكلاسيكية يمكن وصفها بأنها سليمة وقوية، ولكن من ناحية أخرى آلية مشتركة جدا من الاهتمام، وربما حتى أننا نشعر أنه من "الطبيعي". ولكن في الواقع، فإن آلية اهتمام ليست في الحقيقة هو السبيل الوحيد لتعزيز الشبكة. أخذت هذه Distill.pub بلوق المادة لنا لإعادة النظر في مجموعة متنوعة من شبكة بما في ذلك الاهتمام، بما في ذلك تعزيز الطريقة، فإنها تركز على اتجاهات مختلفة، وتسهيل موظفي البحوث / تطوير الذين تم اختيارهم وفقا لاحتياجاتها الفعلية. لى فنغ شبكة AI تقنية مراجعة جمعت على النحو التالي.

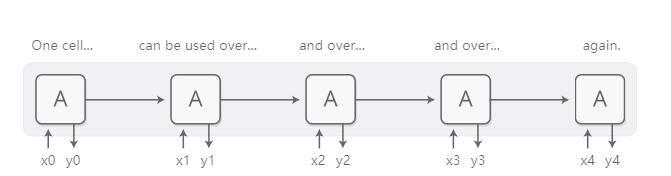

المتكررة الشبكات العصبية (RNN) هو نوع من نموذج تكنولوجيا التعلم في عمق مهم جدا، لأنها تتيح الشبكة العصبية قادرة على معالجة البيانات تسلسل، والنص والصوت والفيديو. يمكن للناس استخدام الشبكة العصبية المتكررة لتسلسل نسبت إلى فهما متقدما للوضع، لذلك تم وضع تسلسل، حتى من البداية إلى توليد سلسلة جديدة.

تتطلب العملية الأساسية لتصميم RNN الصعب معالجة سلاسل طويلة، ولكن نوع خاص RNN --LSTM (طويل الذاكرة على المدى القصير، طويلة شبكة الذاكرة على المدى) يعمل بشكل جيد في هذه الحالة. وقد تبين أن هذه النماذج هي قوية جدا ويمكن أن تحقق نتائج جيدة جدا في عدد من المهام، بما في ذلك الترجمة الآلية، التعرف على الكلام والفهم صورة (كلمات الشكل)، وما شابه ذلك. وهكذا، في السنوات القليلة الماضية، وقد استخدمت الشبكات العصبية المتكررة على نطاق واسع.

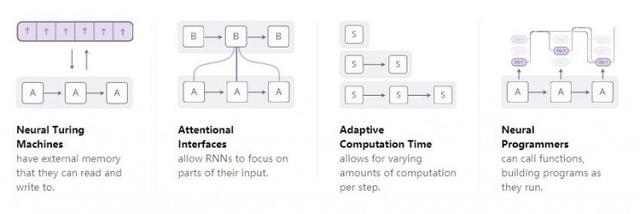

كدراسة الناس للشبكات العصبية المتكررة أكثر وأكثر عمقا، شهدنا المزيد والمزيد من الناس الذين يحاولون استخدام بعض الميزات الجديدة لزيادة الدورة الدموية الشبكات العصبية. هناك أربعة اتجاهات التحسن المثير على وجه الخصوص:

هذه التقنيات، ولكل واحدة من هذه التقنيات قد تحسنت كثيرا الشبكة العصبية. ومع ذلك، فإن بارد الحقيقي أن هذه التكنولوجيات يمكن أيضا استخدام مجموعة من التقنيات الحالية وهذه يبدو أن لديها مساحة بحث واسع إلا في قارب صغير. وعلاوة على ذلك، وأنهم جميعا تعتمد على نفس التقنية الأساسية - آليات الانتباه إلى لعب دور.

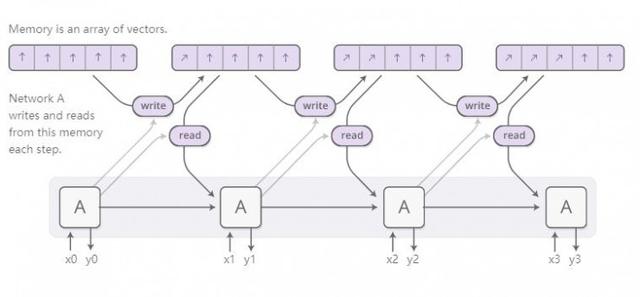

العصبية آلة تورينج

العصبية آلة تورينج مزيج RNN مع وحدة التخزين الخارجية. منذ ناقلات اللغة الطبيعية هو تمثيل للشبكة العصبية، وحدة تخزين المحتوى عبارة عن مجموعة من ناقلات:

ولكن العمل على الجهاز العصبي تورينج لقراءة وكتابة ما هو عليه؟ التحدي الحقيقي هو أننا بحاجة لجعلها للتفاضل. على وجه الخصوص، ونحن بحاجة لجعلها بالنسبة لنا القراءة والكتابة موقف للتفاضل، حتى يتسنى لنا معرفة القراءة والكتابة في مكان. منذ عنوان الذاكرة منفصلة في الأساس، والسماح لهم للاختلاف هو في غاية الصعوبة. تحقيقا لهذه الغاية، وآلة تورينج العصبية يأخذ حل ذكي جدا: انهم يستطيعون القراءة والكتابة في جميع المناصب في خلايا الذاكرة في كل خطوة من العملية، ولكن بدرجات متفاوتة.

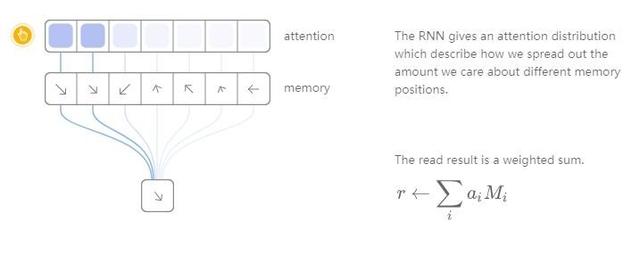

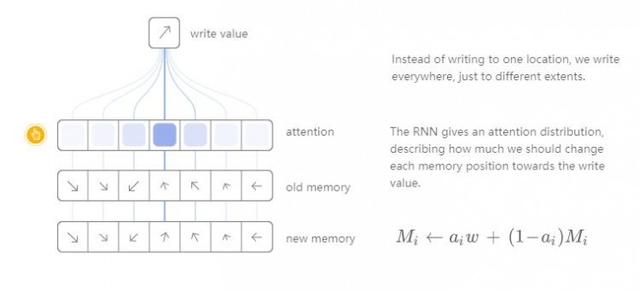

على سبيل المثال، دعونا التركيز على عملية القراءة. RNN لا تحدد موقفا القراءة معين، لكن إخراج "توزيع الانتباه"، الذي يصف توزيع لدينا مواقع تخزين مختلفة للحصول على درجة من الاهتمام. نتائج بالتالي الحصول على عملية القراءة هي مبلغ مرجح.

وبالمثل، وسوف نكتب بدرجات مختلفة في أماكن مختلفة من وحدة التخزين. ونحن نركز مرة أخرى مع توزيع يصف كم نحن كتابة المحتوى في كل موقع. لدينا قيمة جديدة لكل موقع من قبل وحدة التخزين في مجموعة محدب من قيم محتويات التخزين القديمة والجديدة مكتوبة للقيام بذلك، والموقف من محتويات المخزن بين القيم القديمة والجديدة اعتمادا على الوزن من الاهتمام.

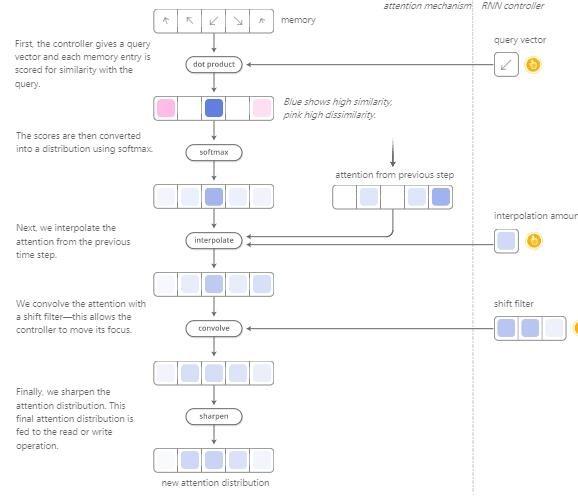

ومع ذلك، العصبية تورينج آلة هي كيفية تحديد أي ضرورة تركيز الاهتمام على موقع وحدة التخزين على ذلك؟ في الواقع، فإنها تستخدم مزيجا من طريقتين مختلفتين: الاهتمام آلية التركيز على أساس آلية والمحتوى القائم على الموقع. استنادا إلى محتويات الآليات العصبية للآلة تورينج الانتباه يمكن البحث ذاكرتهم والتركيز على موقف يبحثون لتتناسب مع الهدف، ولكن على أساس موقف آلية الانتباه هو الحركة النسبية للانتباه وحدة تخزين يصبح ممكن، وآلة تورينج العصبية يمكن إعادة تدويرها.

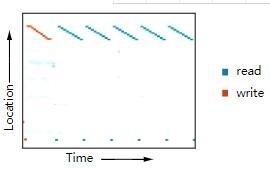

هذا الإلمام بالقراءة والكتابة العصبية مثل هذه آلة تورينج قادرة على أداء العديد من خوارزمية بسيطة، ولكن لا يقتصر على نطاق الشبكة العصبية. على سبيل المثال، قد يتم تخزينها لفترة طويلة تسلسل التعلم في وحدة التخزين، ثم تعرض لركوب الدراجات المتكررة. عندما تفعل ذلك، يمكننا أن نرى لهم أداء القراءة وعمليات الكتابة في موقف ما، من أجل فهم أفضل ما يفعلونه:

يمكنك ان ترى المزيد من النتائج في . ويستند هذا الرقم على الازدواجية المتكررة المستمدة تجريبيا.

كما أنها يمكن أن تتعلم لتقليد الجدول نظرة المتابعة، أو حتى تعلم لفرز أرقام (رغم وجود عدد من الطرق الانتهازية)! من ناحية أخرى، وأحيانا يواجهون فإن بعض العمل الأساسي جدا أن يكون عاجزا، مثل إضافة أو الضرب من العملية الأرقام.

منذ أن تم نشر معظم ورقة العصبي آلة تورينج البدائية، فقد ظهرت عدد كبير من تقدم البحوث مثيرة المحرز في أوراق المجالات ذات الصلة. العصبية GPU تورنج آلة لا يمكن أن تحل الجرأة في طرح أرقام الجمع والضرب. Zaremba وSutskever آخرون استخدام التعزيز تعلم القراءة والكتابة بدلا من اختلاف والأكثر بدائية من الناحية التكنولوجية آلة تورينج العصبي تستخدم لتدريب الترجمة الآلية العصبية. العصبية ذاكرة الوصول العشوائي (NRAM) هو عمل قائم على المؤشر. حاليا، هناك عدد من الأوراق أن كومة وبنية بيانات طابور مثل تفاضل تم استكشافها في . وذكريات (شبكات الذاكرة) هو طريقة أخرى لحل مشاكل مشابهة.

من بعض الشعور موضوعي، يمكن لهذه النماذج أداء العديد من المهام (على سبيل المثال، وتعلم كيفية القيام الأفعى الرقمي)، فإنه ليس من الصعب جدا. لتقنيات البرمجة التقليدية، هذه المهام يمكن أن يقال أن تكون قطعة من الكعكة. ومع ذلك، فإن الشبكة العصبية يمكن التعامل مع العديد من القضايا الأخرى، والقدرة الحالية للنموذج مثل آلة تورينج العصبية يبدو لا تزال تتلقى الكثير من القيود، لا يتم تطويرها بشكل كامل.

قانون

هذه النماذج لديها العديد من النسخة تنفيذ مفتوحة المصدر. تنفيذ مفتوحة المصدر من آلة تورينج العصبية لديها تيهون كيم (Tensorflow نسخة، https: //github.com/carpedm20/NTM-tensorflow)، Shanwn (Theano نسخة، https: //github.com/shawntan/neural-turing-machines)، فومين (العودة نسخة، https: //github.com/fumin/ntm)، كاي شنغ (الشعلة نسخة، https: //github.com/kaishengtai/torch-ntm)، قصاصة (لسان نسخة أو https: // جيثب. كوم / snipsco / بعثة الناتو للتدريب اللازانيا) والإفراج عن آخرين. كود العصبية GPU هو المصدر المفتوح، ويجب أن تدرج فيه (https://github.com/tensorflow/models/tree/master/neural_gpu) مكتبة نموذجية TensorFlow. تنفيذ مفتوحة المصدر من ذكريات تشمل الفيسبوك (الشعلة / ماتلاب نسخة، https: //github.com/facebook/MemNN)، YerevaNN (Theano نسخة، https: //github.com/YerevaNN/Dynamic-memory-networks-in-Theano )، تيهون كيم (TensorFlow نسخة، https: //github.com/carpedm20/MemN2N-tensorflow) والإفراج عن آخرين.

آليات الإنتباه

عندما نترجم الجملة، فإننا سوف تولي اهتماما خاصا لكلام الترجمة الحالية. عندما كنا كتب تسجيل وسنستمع بعناية نحاول كتابة فصول. إذا كنت تريد لي أن أصف غرفة جلوس لي، وأود أن ننظر في جميع أنحاء الجسم في الوقت صفها.

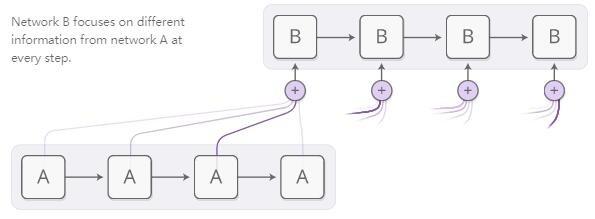

الشبكة العصبية باستخدام آلية الانتباه إلى تحقيق نفس السلوك، والتركيز على جزء من المعلومات التي تم الحصول عليها في البيئة بأكملها. على سبيل المثال، يمكن RNN RNN التعامل مع إخراج البعض. في كل خطوة الوقت، مع إيلاء اهتمام سيركز على آلية محتوى RNN على مواقع مختلفة من RNN الآخرين.

نأمل أن آليات الإنتباه هي اختلاف، حتى يتسنى لنا أن نتعلم التركيز على مضمون موقف ما. للقيام بذلك، ونحن نستخدم هذه الجائزة ونفس العصبية تورينج التكنولوجيا الآلة: نحن قلقون حول كل موقف، ولكن بدرجات متفاوتة من الاهتمام بال.

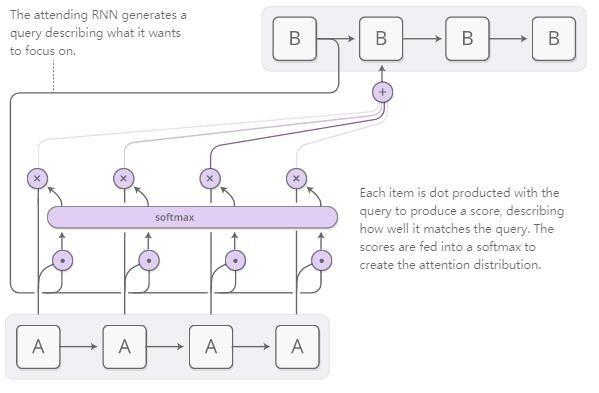

عادة يتم إنشاؤها توزيع الاهتمام من قبل آلية التركيز على أساس المحتوى. كنا تشغيل RNN يولد مصطلح البحث واصفا الموقف الذي يريد الاهتمام. ، وسيتم وصف كل واحد سيحمل على مع كلمة البحث نقطة لتصبح النتيجة درجة مباراة مع النتيجة من مصطلحات البحث. والنتيجة بمثابة مساهمة في وظيفة Softmax لخلق توزيع الاهتمام.

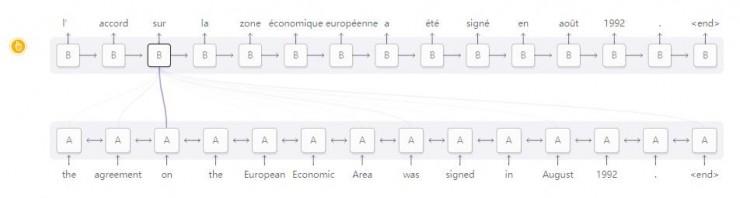

آلية الاهتمام تطبيق المشهد بين RNN هي الترجمة الآلية . يجب تخفيض تسلسل التقليدية إلى نموذج التسلسل (Seq2Seq) إلى ناقلات المدخلات كله واحد، ثم نتيجة الترجمة التي تم الحصول عليها انتشار معكوس. آلية الانتباه لتمرير كل المعلومات كلمة يمكن أن ينظر إليه من قبل عملية RNN المدخلات، وسوف تولد تركز على RNN الانتباه الإخراج على كلمة ذات الصلة.

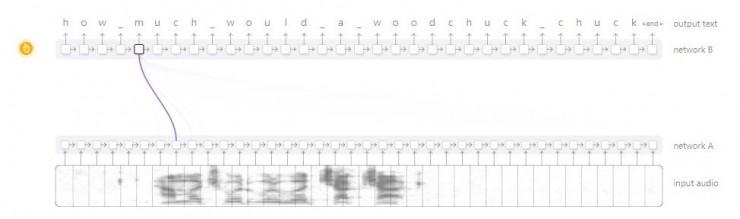

هذه الآلية الاهتمام بين RNN كانت هناك العديد من السيناريوهات الأخرى. فمن الممكن أن ، والذي يستخدم في التعرف على الكلام، بحيث RNN يمكن معالجة المعلومات الصوتية، ومن ثم السماح للRNN آخرين لتصفح ذلك، عندما يولد النص الصوت المطابق للتركيز على الأجزاء ذات الصلة.

التطبيقات الأخرى مثل هذه الآليات إلى مزيد من الاهتمام تضم النص إعراب ، وآلية ثم التركيز على النموذج كلمة يمكن مسحها أثناء إنشاء شجرة تحليل. في النمذجة الحوار مهمة، وآليات الإنتباه بحيث نموذج يمكن أن تولد استجابة في النص، مع التركيز على المتطلبات ذات الصلة محتوى الدورة السابقة.

ويمكن أيضا أن تستخدم آلية الاهتمام على التفاعل بين الشبكة العصبية التلافيف ودورة الشبكة العصبية. آلية الانتباه هنا يمكن أن تجعل RNN المواقف المختلفة في كل خطوة من الصورة المثيرة للاهتمام. A تطبيق سيناريوهات شعبية آلية هذا الاهتمام هو "المكونات الكلام." أولا، صورة التفاف من أجل تحويلها الى مستوى الشبكة استخراج ميزة، RNN ثم قم بتشغيل زوج من الصور الناتجة الوصف. عندما يولد كل كلمة في الوصف، RNN شرح ستركز التفاف الشبكة العصبية في الأجزاء ذات الصلة من الصورة. يمكننا عرض التصور للعملية FIG:

وعلى نطاق أوسع، عندما نريد أن نكرر مع العصبية لرسو السفن هندسة الشبكات في الإخراج، يمكنك استخدام واجهة للانتباه.

تبين أن اهتمام واجهة هو قيمة تنوعا للغاية وتقنية قوية جدا، ويتم استخدامه على نطاق واسع على نحو متزايد.

التكيف الحاسبات الوقت

إجراء نفس العدد من الحسابات القياسية RNN على كل خطوة الوقت. هذا لا يبدو بديهية. بالطبع، يجب أن المشكلة أننا نتعامل مع يصبح أكثر تعقيدا، وأكثر الناس يعتقدون حول ما إذا كان ذلك؟ وبالإضافة إلى ذلك، وطول قياسي العملية سوف RNN وقت تعقد سلسلة ن يقتصر على O (ن).

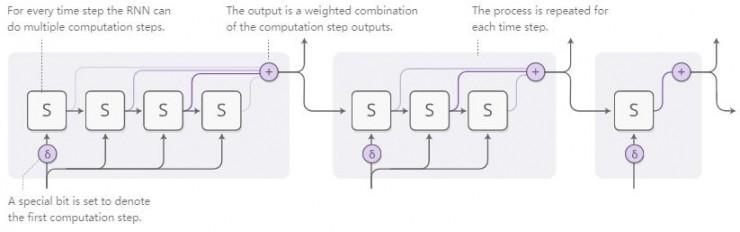

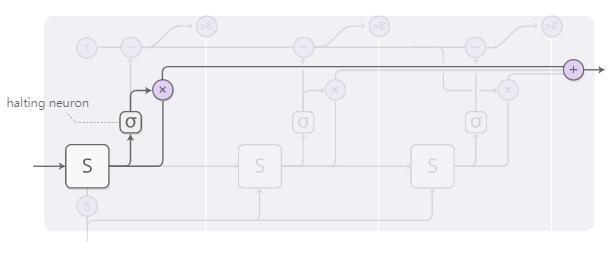

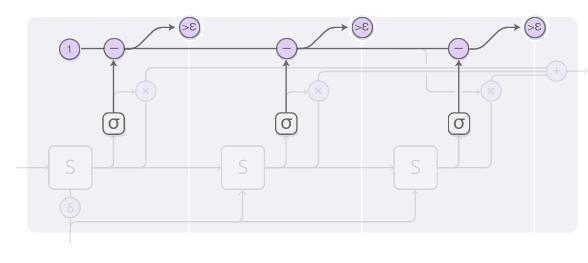

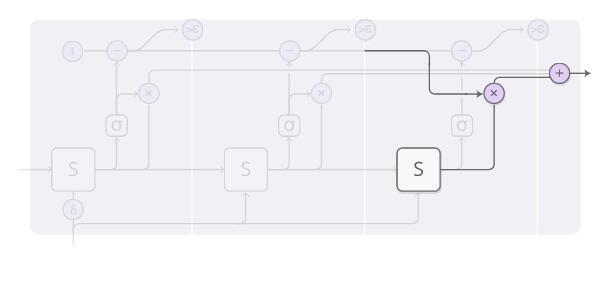

التكيف وقت الحساب كل خطوة هي طريقة قادر على حساب عدد الصفوف في صنع مختلف RNN. الفكرة العامة هي في غاية البساطة: فهو يسمح RNN يمكن أن تؤدي حساب متعددة الخطوات في كل خطوة الوقت.

من أجل الشبكة لمعرفة عدد الخطوات التي يتعين احتساب، ونحن نأمل أن عدد من الخطوات للاختلاف. وقد استخدمنا التكنولوجيا لدينا لتحقيق ذلك: نحن لا تشغيل عدد محدد من الخطوات، ولكن استخدام عدد من الخطوات لتشغيل اهتمام الموزعة. انتاجها هو مزيج المرجح لإخراج كل خطوة.

يتجاهل هذا الرقم أيضا بعض مزيد من التفاصيل. هذا الرقم هو الرسم التخطيطي الكامل في خطوة وقت الحساب ويضم ثلاث خطوات:

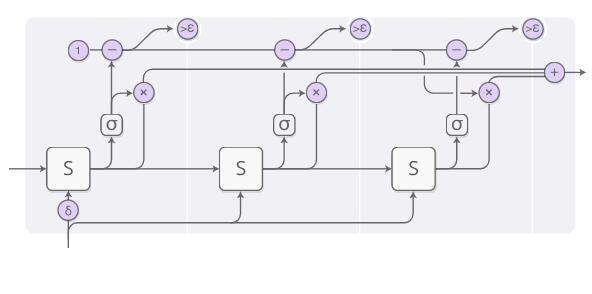

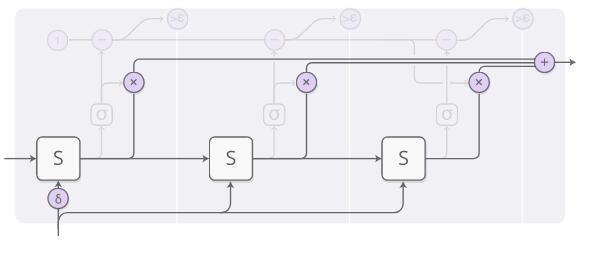

مخطط عملية حسابية يصور معقدة بعض الشيء، لذلك اسمحوا لنا تحليل ذلك خطوة خطوة. في الجزء العلوي، ونحن لا تزال تعمل الناتج RNN ومزيج المرجح لدولة:

كل خطوة من الأوزان الثقيلة يحسب بقرار "العازلة الخلايا العصبية. بل هو وسيلة لمراقبة حالة RNN ويعطي الوزن الثقيل من الخلايا العصبية عازلة السيني، يمكننا أن نقول أنه هو احتمال أن علينا أن نتوقف عند هذه المرحلة من.

لدينا مجموع الحد ميزانية الوزن المخزن المؤقت 1، وتدفق ثم حسبنا في الصف العلوي من FIG حساب (بدءا من 1، في كل خطوة من طرح قيمة المقابلة). عندما يصبح أقل من إبسيلون، نتوقف العد.

عندما نتوقف، قد يكون لها أيضا بعض سادة في الميزانية لم ينته خارج الجزء الحوسبة، وذلك لأن سنوقف حساب عندما يكون أقل من إبسيلون. كيف نتعامل مع هذا الوضع؟ من الناحية الفنية، أنه تم إعطاء الخطوات لمواصلة مستقبل الحوسبة، ونحن لا نريد الاعتماد عليه، لذلك نحن الآن سوف يتم تعريف الدولة على أنها الخطوة الأخيرة.

عندما ندرب نموذج الحوسبة الوقت على التكيف، يمكنك إضافة إلى فقدان وظيفة في "تقييم التكاليف" (التكلفة يتأمل)، ويتم استخدامها لحساب نموذج وقت العقاب التراكمي. وهذا هو أكبر وأكثر لأنه سوف يقلل من الوقت اللازم للحساب وخفض الأداء وتحقيق أغراض التسوية.

الوقت التكيف الحاسبات فكرة جديدة جدا، ولكننا نعتقد أنها وأفكار مماثلة مهمة جدا.

قانون

و"التكيف الحاسبات تايم" نموذج فقط من المصادر المفتوحة ويبدو أن مارك نيومان إصدار (TensorFlow نسخة، https: //github.com/DeNeutoy/act-tensorflow).

الشبكات العصبية مبرمج

أداء الشبكة العصبية في العديد من المهام جيدة جدا، ولكنها أيضا من الصعب جدا أن تفعل بعض الأشياء الأساسية. على سبيل المثال فإنه من الصعب للشبكة العصبية الحسابية، وهو أمر شائع لحساب غير سهلة. إذا كان هناك طريقة لدمج الشبكات العصبية وأساليب البرمجة المشتركة معا، ونحن سوف تحصل على أكبر وضع مربح للجانبين.

الشبكات العصبية البرمجة هي طريقة حل هذه المشكلة. وسوف تتعلم لإنشاء برنامج لحل هذه المشكلة. في الواقع، يمكن لمثل هذه الإجراءات تولد دون الحاجة الإجراء الصحيح من القالب مثال. وجدت أنه من أجل إنجاز مهمة، كوسيلة لكيفية إنتاج الإجراءات المطلوبة.

نموذج ورقة الفعلي للإجابة على هذا السؤال من خلال توليد SQL مثل برنامج جدول الاستعلام. ومع ذلك، فإن الكثير من التفاصيل في هذه البيئة لجعلها أكثر معقدة بعض الشيء. ولذا فإننا قد يتصور من نموذج البداية أسهل قليلا، مما يعطي التعبير الحسابي، وتوليد نموذج لتقييم ذلك.

البرنامج الذي تم إنشاؤه هو سلسلة من العمليات. ويعرف كل عملية والإخراج من العمليات السابقة للعمل. وهكذا، فإن المشغل قد يشبه "عمليات الانتاج من خطوتين السابقة وعمليات الانتاج قبل الخطوة إضافة". هو أشبه خط أنابيب يونكس، بدلا من أن يتم تعيين متغير برنامج وقراءة.

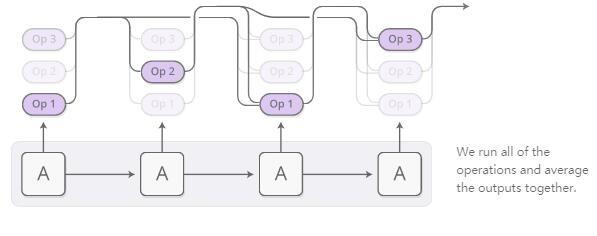

برنامج يولد العملية الأولى قبل وحدة تحكم RNN. في كل خطوة، وإخراج تحكم RNN ما ينبغي أن يكون عملية المقبل لتوزيع الاحتمالات. على سبيل المثال، وهذا احتمال يمكن استخدامها لمحاكاة: نحن يمكن أن يكون متأكد جدا أننا نريد أن تؤدي إلى ذلك في خطوة لأول مرة، ومن ثم تقرر ما إذا كنا بحاجة إلى أن يكون من الصعب جدا في بعض الأحيان لأداء الضرب أو القسمة من الخطوة الثانية، وهلم جرا ...

الآن، وهذه العملية من توزيع النتائج النهائية للتقييمنا يمكن أن يكون. نحن لسنا في كل خطوة من تشغيل عملية، بدلا من استخدام أسلوب يستخدم عادة الانتباه أثناء تشغيل جميع العمليات، ثم بلغ متوسط معا كل من خرج على أساس احتمال أننا تنفيذ هذه العمليات كما الأوزان.

طالما أننا يمكن أن تحدد هذه العمليات مشتق من برنامج إخراج احتماليا هو للتفاضل. ثم، يمكن أن نحدد وظيفة الخسارة، لتدريب برنامج توليد الشبكة العصبية يعطي الإجابة الصحيحة. ونتيجة لذلك، فإن العصبية يتعلم شبكة مبرمج لتوليد في غياب إجراءات الدعوى الإجراءات المناسبة النموذج. المعلومات الوحيدة التي هي تحت إشراف برنامج يجب أن ينتج قيمة المقابل.

هذه هي الفكرة الأساسية للبرمجة الشبكات العصبية، ولكن النسخة الورقية من الإجابة على سؤال حول الطاولة، بدلا من التركيز على تعبيرات حسابية. هنا سوف نقدم بعض النصائح العملية:

-

أنواع بيانات متعددة: العصبية عملية برمجة الشبكات سيتم التعامل معها في العديد من أنواع أخرى من البيانات الأخرى من القيم القياسية. بعض العمليات العمود الناتج من الجدول المحدد أو الخلايا المحددة. فقط نفس النوع من الانتاج يمكن دمجها معا.

-

إشارة المدخلات: المبرمجين الشبكة العصبية تحتاج إلى الإجابة على غرار "؟ وكم يبلغ عدد سكانها أكثر من مليون شخص في المدينة" من أجل جعلها أسهل للإجابة على هذا السؤال، وبعض من عمليات يسمح لهم إشارة شبكة ثابت إلى الإجابة على الأسئلة، أو عمود ومن الأسماء. ويرجع ذلك إلى آلية التركيز المرجعية، ومؤشرات شبكة .

برمجة الشبكة العصبية ليست هي الطريقة الوحيدة لتوليد الشبكة العصبية يسمح البرنامج. طريقة جيدة أخرى هو العصبي جهاز برمجة الشبكات - مترجم ، وانه يمكن القيام بالكثير من المهام مثيرة للاهتمام، ولكن الحاجة إلى ضمان البرنامج بأنها المعلومات تحت الإشراف.

ونحن نعتقد أن هذا الجسر الفجوة بين البرمجة التقليدية والشبكات العصبية عموما الفضاء مهم جدا. على الرغم من أن الشبكة العصبية البرمجة هو واضح ليس الحل النهائي، وأعتقد أن واحدة وهناك العديد من الدروس الهامة التي يمكن استخلاصها من ذلك.

قانون

وكانت أحدث نسخة من Q & A للمبرمج الشبكة العصبية (https://openreview.net/pdf؟id=ry2YOrcge) مفتوح المصدر مؤلفيها، والحصول على نموذج TensorFlow يمكن أن تستخدم (https://github.com/tensorflow/models / شجرة / سيد / neural_programmer). برمجة الشبكات العصبية - مترجم أيضا Keras إصدار (https://github.com/mokemokechicken/keras_npi) تأليف كين موريشيتا.

فهم شامل

بمعنى من المعاني، إنسان يحمل قطعة من الورق، أكثر ذكاء بكثير من تلك التي من دون أوراق. ويمكن للرجل الرموز الرياضية في حل المشاكل التي لا يمكن حلها. استخدام الكمبيوتر بحيث يمكننا أن نجعل إنجازا لا يصدق، وإلا فإنها ستكون أبعد من قدراتنا.

بشكل عام، شكل ويبدو أن الكثير من التفاعل الفكري للاهتمام بين الإبداع البشري والحدس بعض وسائل الإعلام الاستدلال محددة أكثر بديهية، مثل اللغة أو المعادلات. في بعض الأحيان، وسائل الإعلام هو شيء موضوعي بالنسبة لنا لتخزين المعلومات، يمنعنا من الوقوع في الخطأ، أو تنفيذ مهام معقدة الحوسبة. وفي حالات أخرى، وسائل الإعلام هو النموذج الذي نحن التلاعب في العقل. في أي حال، من المهم جدا للاستخبارات.

النتائج الأخيرة للتعلم الآلة قد بدأت في الحصول على طعم الجمع بين الحدس الشبكة العصبية وغيرها من الامور. طريق واحد هو ما يسميه الناس "بحث ارشادي." على سبيل المثال، AlphaGo لدينا نموذجا لكيفية الذهاب الى العمل، واستكشاف نموذج لكيفية لعب هذه اللعبة في العصبي دليل شبكة الحدس. وبالمثل، DeepMath تتميز عملية بديهية من تعبير رياضي باستخدام الشبكة العصبية. في هذه المقالة تحدثنا عن "تعزيز RNN" هو وسيلة أخرى للاتصال وسائل الإعلام RNN مصممة خصيصا لتحسين القدرة على تعميم بهم.

التفاعل الطبيعي مع وسائل الإعلام وتشمل "مجموعة من الإجراءات، لمراقبة، ومن ثم اتخاذ مزيد من الإجراءات." هنا، نحن نواجه تحديا كبيرا: كيف يمكننا معرفة ما ينبغي اتخاذ إجراءات؟ هذا يبدو وكأنه تعزيز مشاكل في التعلم، وبالطبع يمكننا تبني هذا النهج. ومع ذلك، والتعلم تعزيز التكنولوجيا في حل المشكلة هي في الواقع أكثر تعقيدا نسخة، وهذا الحل الصعب استخدام. الأبعاد الخفية للآلية اهتمام هو أنه يسمح لنا بالمرور بسهولة أكبر على بعض يمكنها من تنفيذ كافة الإجراءات بدرجات متفاوتة، من أجل حل هذه المشكلة. وذلك لأن يمكننا تصميم هياكل التخزين مثل الأعصاب تورنج آلة حتى نتمكن من تنفيذ عمليات قاصر، وأن المشكلة يمكن أن يكون الحد الأدنى. تعزيز التعلم دعونا نأخذ مسار حل واحد، ومحاولة لتعلم المعارف. آلية الاهتمام المختارة في كل تقاطع لاتخاذ الإجراءات اللازمة في كل الاتجاهات، وسوف نتائج كل مسار دمج معا في نهاية المطاف.

والعيب الرئيسي لآلية الانتباه هو أن علينا أن نأخذ "العمل" في كل خطوة. لأننا سوف يتم زيادة العصبية تشغيل آلة تورنج في وحدة الذاكرة أو ما شابه ذلك، والتي يمكن أن تؤدي إلى النفقات العامة الحسابية بشكل مستقيم. يمكن للحلول يفكر هو السماح انتباهكم بعض من طراز يصبح متفرق، وذلك منذ ما عليك سوى جزء من خلية الذاكرة للعمل. ومع ذلك، فإنه لا يزال يشكل تحديا، لأنك قد ترغب في الحصول على نموذج انتباهكم يعتمد على محتويات وحدة التخزين، ولكن القيام بذلك سيجعل لديك للنظر في كل خلية الذاكرة. وقد لاحظنا أن هناك بعض الأعمال الأولية في الحس السليم لحل هذه المشكلة، مثل ، ولكن يبدو أن هناك الكثير من العمل الذي ينبغي استكشافها. إذا كنا حقا يمكن أن تجعل من عمل الآليات الاهتمام في هذا الخطية في تعقيد الوقت، وهذا النموذج تصبح قوية جدا!

شبكات تعزيز الدورة الدموية العصبية وآليات الإنتباه التكنولوجيا الأساسية هي مثيرة جدا! ونحن نتطلع في هذا المجال هناك تقنيات جديدة أكثر الظهور!

مراجع

1. شبكات LSTM فهم (Http://colah.github.io/posts/2015-08-Understanding-LSTMs)Olah، C.، 2015.

2. العصبية تورينج MachinesGraves، A.، اين، G. وDanihelka، I.، 2014. كور، المجلد ABS / 1410،5401.

3. مشاهدة، حضور وأقول: العصبية توليد صورة توضيحية مع الانتباه البصري شو، K.، با، J.، كيروس، R.، تشو، K.، كورفيل، A.، Salakhutdinov، R.، Zemel، RS وBengio ، Y.، 2015. أرخايف ورقة أرخايف :. +1502.03044، المجلد 2 (3)، ص 5. كور.

4. العصبية وحدات معالجة الرسومات تعلم AlgorithmsKaiser، L. وSutskever، I.، 2015. كور، وتقاسم المنافع المجلد / +1511.08228.

5. التسليح التعلم العصبية تورينج MachinesZaremba، W. وSutskever، I.، 2015. كور، وتقاسم المنافع المجلد / +1505.00521.

6. العصبية الوصول العشوائي آلات Kurach، K.، Andrychowicz، M. وSutskever، I.، 2015. كور، وتقاسم المنافع المجلد / +1511.06392.

7. تعلم تنبيغ مع غير محدود الذاكرة Grefenstette، E.، هيرمان، K.M.، سليمان، M. وBlunsom، P.، 2015. التقدم في العصبية نظم المعلومات تجهيز 28، ص 1828-1836. كوران شركاه، وشركة

8. أنماط استنتاج حسابي مع المكدس المعقم المتكررة شبكات Joulin، A. وMikolov، T.، 2015. التقدم في العصبية نظم المعلومات تجهيز 28، ص. 190-198. كوران شركاه، وشركة

9. الذاكرة الشبكات ويستون، J.، شوبرا، S. وبوردس، A.، 2014. كور، وتقاسم المنافع المجلد / 1410،3916.

10. يطلب مني شيئا: شبكات ذاكرة ديناميكية للمعالجة اللغات الطبيعية كومار، A.، Irsoy، O.، سو، J.، برادبري، J.، الإنجليزية، R.، بيرس، B.، اوندروسكا، P.، Gulrajani، I. وسوشر، R.، 2015. كور، المجلد ABS / +1506.07285.

11. العصبية الترجمة الآلية عن طريق التعلم معا لمواءمة وترجمة Bahdanau، D.، تشو، K. وBengio، Y.، 2014. أرخايف ورقة أرخايف: 1409،0473.

12. الاستماع، وحضور والإملائي تشان، W.، Jaitly، N.، لو، بقدر المراد وVinyals، O.، 2015. كور، المجلد ABS / +1508.01211.

13. قواعد اللغة باعتبارها لغة أجنبية Vinyals، O.، كايزر، L.، كو، T.، بيتروف، S.، Sutskever، I. وهينتون، G.، 2015. التقدم في العصبية أنظمة معالجة المعلومات، ص 2773- 2781.

14. العصبية المحادثة نموذج Vinyals، O. ولو، بقدر المراد 2015. كور، وتقاسم المنافع المجلد / +1506.05869.

15. التكيف وقت الحساب لالمتكررة الشبكات العصبية القبور، A.، 2016. كور، وتقاسم المنافع المجلد / +1603.08983.

16. العصبية مبرمج: حمل برامج الكامنة مع التدرج DescentNeelakantan، A.، لو، بقدر المراد وSutskever، I.، 2015. كور، المجلد ABS / +1511.04834.

17. مؤشر شبكات Vinyals، O.، فورتوناتو، M. وJaitly، N.، 2015. التقدم في العصبية أنظمة معالجة المعلومات، ص 2692-2700.

18. العصبية مبرمج-InterpretersReed، S.E. وفريتاس، بدون تاريخ، عام 2015. كور، المجلد ABS / +1511.06279.

19. اتقان لعبة الذهاب مع الشبكات العصبية العميقة وsearchSilver شجرة، D.، هوانغ، A.، ماديسون، CJ، Guez، A.، Sifre، L.، Driessche، Gvd، Schrittwieser، J.، Antonoglou، I. ، Panneershelvam، V.، Lanctot، M.، Dieleman، S.، Grewe، D.، Nham، J.، Kalchbrenner، N.، Sutskever، I.، Lillicrap، T.، ليتش، M.، Kavukcuoglu، K. .، Graepel، T. وHassabis، D.، 2016. الطبيعة، المجلد 529 (7587)، ص 484-489 الطبيعة مجموعة النشر دوى: 10.1038 .. / nature16961

20. DeepMath - نماذج ديب تسلسل لفرضية اختيار Alemi، A.A.، Chollet، F.، ايرفينغ، G.، Szegedy، C. والتنمية الحضرية، J.، 2016. كور، المجلد ABS / +1606.04442.

21. تعلم الخوارزميات الفعالة مع الهرمي اليقظة الذاكرة Andrychowicz، M. وKurach، K.، 2016. كور، المجلد ABS / +1602.03218.

عبر التقطير، شبكة لى فنغ جمعت AI تقنية مراجعة