في هذه الورقة، ويفسر بعض خريطة متحركة صورة آلية من الاهتمام، ويشارك أيضا في السنوات الخمس الماضية ظهرت أربعة العمارة NMT، تظهر بعض المفاهيم في النص أيضا تفسير بديهية.

مختارة من TowardsDataScience، الكاتب: الريمي الكريم والمشاركة: شوان الطريق السريع.

على مدى عقود، وكانت الترجمة الآلية الإحصائية في نموذج الترجمة المهيمنة حتى الأعصاب في الترجمة الآلية (NMT) تظهر. NMT هو طريقة جديدة لالترجمة الآلية، فإنه يحاول بناء وتدريب الشبكة العصبية على نطاق واسع واحدة، والتي تنص على إدخال النص والإخراج الترجمة .

NMT الأبحاث الرائدة في الأصل من Kalchbrenner وBlunsom (2013)، Sutskever وآخرون (2014) وتشو، وآخرون (2014b) ثلاث ورقات، والتي نحن الإطار أكثر دراية تسلسل Sutskever آخرون رقة مقدمة إلى التسلسل ( seq2seq) الدراسة. وتصف هذه الورقة كيفية بناء الاهتمام على الإطار seq2seq.

FIG 0.1: seq2seq، وتسلسل المدخلات من طول 4

في seq2seq، الفكرة الأولية هي أن يكون دورتين الشبكات العصبية (RNN) التي تشكل المبرمج - فك العمارة: كلمة التشفير المدخلات قراءة واحدا تلو الآخر، للحصول على ثابت تمثيل ناقلات البعد، وRNN الأخرى (فك) بناء على هذه المدخلات استخراج الانتاج بمقدار كلمة واحدة.

FIG 0.2: seq2seq، وتسلسل المدخلات من طول 64

مشكلة seq2seq هو أن فك المعلومات الواردة من التشفير فقط هو "مخفية التشفير الماضي" (أحمر عقدتين في FIG 0.1)، الذي يشبه سلسلة من المدخلات الرقمية ناقلات تمثيل تلخيصها. وهكذا، ليعد إدخال النص (الشكل 0.2)، إذا كنا لا تزال تريد استخدام وحدة فك الترميز منها سوى تمثيل متجه (أمل أن "يلخص تماما تسلسل المدخلات") لإخراج الترجمة، أنه من غير المعقول. وهذا يمكن أن يؤدي إلى كارثة منسية. وكان هذا الممر 100 كلمة، يمكنك ترجمتها على الفور إلى لغة أخرى؟

وإذا كنا لا نستطيع، ثم لا تكون قاسية جدا على وحدة فك الترميز. إذا قمت بتوفير كل التشفير على فك خطوة الساعة التمثيل ناقلات، بدلا من مجرد تمثيل متجه، ليست يمكنك الحصول على نتائج أفضل ترجمة؟

إدخال آليات الاهتمام.

FIG 0.3: آليات الإنتباه أدرجت كحلقة وصل بين وفك التشفير. هنا، يتم إعطاء أول خطوة وقت فك قبل أول ترجمة رسالة كلمة وردت من التشفير

الاهتمام هو واجهة بين وفك التشفير، يقدم كل ترميز المعلومات سرية (باستثناء الأحمر مخبأة في FIG. 0.3) هو فك. مع هذا الإعداد، وهذا النموذج هو قادر على التركيز بشكل انتقائي الجزء المفيد من تسلسل المدخلات، وتعلم therebetween المحاذاة. هذا النموذج يساعد على معالجة الجمل الطويلة إدخال فعال.

محاذاة محددة: وسائل محاذاة أجزاء من النص الأصلي المقابلة لشظايا مباراة الترجمة.

الشكل 0.4: الكلمة الفرنسية "لا" في توزيع محاذاة في تسلسل المدخلات، ولكن أساسا على هذه الكلمات الأربع: "ال"، "الأوروبي"، "الاقتصادية" و "المنطقة". يمثل الأرجواني الانتباه إلى درجة أعلى. (FIG المصدر: الشبكي: //distill.pub/2016/augmented-rnns/#attentional-interfaces)

هناك نوعين من الآليات الاهتمام. يشار جميع أجهزة تشفير نوع من الاهتمام خفية أيضا من الاهتمام العالمي. الاهتمام محليا باستخدام مجموعة فرعية فقط من الدولة التشفير المخفية. وتصف هذه الورقة الاهتمام العالمي، لذلك أية مراجع "الانتباه" هنا لهي وسيلة "الاهتمام العالمي."

في هذه الورقة، والرسوم المتحركة وضع آلية الاهتمام، بحيث أننا لا نفهم في حالة من الصيغ الرياضية يمكن أن نفهم على نحو أفضل. في الحالة، فإن مؤلف سهم ظهرت في السنوات الخمس الماضية، أربعة العمارة NMT، بعض المفاهيم في هذه المقالة سوف تفعل أيضا بعض التفسير بديهية.

1. نظرة عامة على الاهتمام

قبل النظر في الاهتمام، وتعلم كيفية استخدام مبادئ مهام الترجمة وراء نموذج seq2seq.

مبدأ seq2seq: المترجم النص الألماني لقراءة من البداية الى النهاية. بعد الانتهاء من القراءة، وبدء النص كلمة كلمة إلى اللغة الإنكليزية. إذا كانت العقوبة هي فترة طويلة جدا، فإنه قد نسيت محتويات ما سبق.

هذا هو نموذج بسيط seq2seq. وصف فورا أدناه لاحظت seq2seq + نموذج الاهتمام طبقة حساب خطوة. وفيما يلي مبادئ بديهية للنموذج.

seq2seq + الانتباه مبدأ: المترجم النص الألماني لقراءة من البداية الى النهاية وتسجيل كلمات، ثم سيتم ترجمة النص إلى اللغة الإنكليزية. عندما الترجمة الألمانية من كل كلمة، والمترجم استخدام السجلات الكلمات الرئيسية.

عن طريق تعيين رصيده الى كل كلمة، والانتباه إلى تعيين اهتمام مختلف لكلمات مختلفة. ثم استخدم softmax التشفير مخبأة المرجح ناقلات مبلغ السياق حصلت (ناقلات السياق). طبقة الانتباه يمكن تحقيق أربع خطوات.

الخطوة 0: إعداد المخفية.

أولا إعداد فك أول سرية (أحمر) وجميع أجهزة تشفير المتاحة سرية (الخضراء). مثال 4 حالة التشفير وحدة فك الترميز الحالي المخفية مخفية.

الشكل 1.0: مستعد للاهتمام

الخطوة 1: الحصول على كل التشفير مخبأة الكسر.

جزء (العددية) من خلال وظيفة التسجيل (يشار أيضا إلى وظيفة درجة المواءمة أو نموذج المحاذاة ). في هذا المثال، وظيفة النتيجة هي نتاج نقطة بين وحدة فك الترميز والتشفير المخفية.

حول مختلف الوظائف النتيجة، يرجى الاطلاع على الملحق A.

الشكل 1.1: تسجيل نقاط

* Decoder_hidden * = * النتيجة Encoder_hidden * --------------------- 15 (= 10 0 + 5 1 + 10 1، ونقطة المنتج) 60 15 35في المثال أعلاه، نحصل على التشفير مخبأة 60 يسجل اهتماما كبيرا. وهذا يعني أن الكلمة التالية إلى أن تترجم سوف تتأثر بشكل كبير من هذه الدولة التشفير المخفية.

الخطوة 2: تشغيل من خلال طبقة جميع الدرجات softmax.

نضع طبقة على درجة softmax، وعشرات softmaxed (سكالارس) هي واحدة. هذه الحسابات تمثيلية من AttentionScape softmax .

الشكل 1.2: النتيجة softmax التي تم الحصول عليها

* Encoder_hidden درجة درجة ^ * ----------------------------- 150 601 150 350علما بأن النتيجة استنادا softmax النتيجة ^، والاهتمام ينبغي توزيع كما هو متوقع على. في الواقع، فإن هذه الأرقام ليست ثنائية، ولكن عددا نقطة عائمة بين 0-1.

الخطوة 3: النتيجة عن طريق كل softmax التشفير تضاعفت الدولة الخفية.

(عددي) بضرب كل التشفير مخبأة softmax النتيجة التي تم الحصول عليها ناقلات انحيازها أو المسمى ناقلات . هذه هي الآلية المحاذاة.

الشكل 1.3: الحصول على المحاذاة ناقلات

* Encoder_hidden درجة درجة ^ محاذاة * ---------------------------------------- 150 601 150 350هنا، ونحن نرى أن يتم تقليل محاذاة كل الترميز مخبأة خارج الاهتمام نظرا لدرجة منخفضة، بالإضافة إلى 0. وهذا يعني أن أول ترجمة للكلمة يجب أن يكون كلمة المدخلات مباريات التضمين.

الخطوة 4: مجموع ناقلات المحاذاة.

مجموع ناقلات المحاذاة، يولد ناقلات السياق . ناقلات السياق هي عبارة عن مجموعة من المعلومات قبل مزيد من ناقلات المحاذاة.

الشكل 1.4: الحصول على ناقلات السياق

* Encoder_hidden درجة درجة ^ محاذاة * ---------------------------------------- 150 601 150 350 * السياق * =خطوة 5: سياق فك ناقلات المدخلات

ذلك يعتمد على تصميم الهندسة المعمارية. نحن سنرى لاحقا في المثال 2A، 2B و2C في القسم كيفية أبنية باستخدام ناقلات السياق في فك مختلفة.

الشكل 1.5: سياق فك ناقلات المدخلات

في هذه المرحلة، الانتهاء من جميع الخطوات. الرسوم المتحركة مثال الشكل:

الشكل 1.6: آليات الإنتباه

كيف الآليات في الانتباه تشغل؟

الجواب: العودة نشر، نعم، وهذا هو العودة نشر! وظهر انتشار بذل كل جهد ممكن لضمان أن نفس الإخراج مع القيمة الحقيقية. ويتحقق ذلك عن طريق تغيير الأوزان RNN وظائف سجل (إن وجدت). وهذه الأوزان يؤثر على فك التشفير وإخفاء مخفي، مما يؤثر على عشرات الاهتمام.

2. أمثلة من الاهتمام

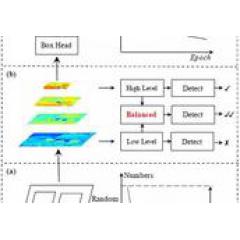

في الجزء السابق ونحن نعلم بالفعل seq2seq وseq2seq + اهتمام الهندسة المعمارية. في المقطع التالي، سوف ندرس العمارة الأخرى التي تتخذ من NMT الانتباه ثلاثة seq2seq. لأجل اكتمال بلو بالإضافة إلى قيمهم - معيار لتقييم الحكم لتوليد الجملة المرجعية.

2A. Bahdanau et.al (2015)

هذا المقال هو تحقيق المناطق الرائدة الانتباه للاهتمام. يستخدم المؤلف "العصبية آلة الترجمة من قبل تعلم بالاشتراك محاذاة وترجمة" في "محاذاة" ورقة كلمة تشير إلى أن تعديل تؤثر بشكل مباشر على النتيجة من الأوزان خلال نموذج التدريب. وفيما يلي تفاصيل العمارة:

التشفير هو ثنائية الاتجاه (إلى الأمام إلى الخلف +) المعزولة وحدة تداول (BiGRU). وحدة فك الترميز هو GRU، التي كانت مخبأة في البداية من GRU عكس التشفير تصحيح خفية من ناقلات النهائي (لا يظهر في الشكل أدناه).

وظائف طبقات الاهتمام التهديف هي مضافة / CONCAT.

المقبل فك الخطوة مدخلا شلال بين الناتج من الخطوة السابقة مرة فك (الوردي) والخطوة الزمنية الحالية (الأخضر الداكن) في سياق النواقل.

. FIG 2A: Bahdanau et.al. من NMT. التشفير هو BiGRU، وحدة فك الترميز هو GRU

يتم الحصول على العمارة في مجموعة البيانات إلى الإنجليزية WMT'14 قيمة BLEU من 26.75.

seq2seq مع اتجاهين الاهتمام التشفير + العمارة:

مترجم يقرأ الكلمة سجل الألمانية في النص. الترجمة B (دور أكثر بارز، لأنه يمكن أن تقرأ من الخلف إلى الأمام) من النص الألماني لقراءة نفسه من الخلف، في حين مذكرة من الكلمات الرئيسية. اثنين من المترجمين وبانتظام "تبادل" كل كلمة يقرأون. بعد قراءة النص الألماني بأكمله، المترجم B هو المسؤول عن اختيارهم المشترك ل"نتيجة الصرف" والكلمة شاملة، والكلمة الألمانية عن الجملة كلمة في اللغة الإنجليزية.

والمترجم هو RNN إلى الأمام، B هو متخلف الترجمة RNN.

2B. لونغ وآخرون (2015)

"اعتبارا من مقاربات العصبية الترجمة الآلية القائمة على الاهتمام" يبسط المؤلف ويعمم العمارة Bahdanau:

- التشفير هو اثنين من الذاكرة على المدى القصير والطويل (LSTM) الشبكة. لديه فك أيضا نفس العمارة، والذي هو آخر التشفير مخفي الأولي المخفية. أنها تجربة مع سجل وظائف هي: (أ) المضافة / CONCAT، (ب) نقطة المنتج، (ج) تعتمد على الموقع و(د) "عام". تتالي بين مخرجات السياق الحالي للخطوة الوقت ناقلات فك والخطوة الزمنية الحالية هي مساهمة في شبكة ال feedforward، والإخراج النهائي للفك للحصول على خطوة الزمنية الحالية (وردي).

FIG 2B: لونغ et.al. من NMT. كل من التشفير وLSTM طبقة فك 2

في WMT'15 الإنجليزية - بيانات الألماني، اكتسبت نموذج القيمة BLEU من 25.9.

2 يتضمن طبقة كومة التشفير seq2seq + العمارة اهتمام:

مترجم يقرأ الكلمة سجل الألمانية في النص. وبالمثل، فإن الترجمة B (أعلى من A) قراءة النص نفسه باللغة الألمانية، في نفس الوقت الكتابة أسفل الكلمات الرئيسية. على المترجم أن يقدم تقريرا إلى B عندما مترجم على مستوى منخفض للقراءة كل كلمة. بعد الانتهاء من القراءة، والتي سيتم على أساس مجموعة شاملة مشتركة من الكلمات الرئيسية، ترجمة الجملة بكلمة إلى اللغة الإنكليزية.

2C، وأن Google العصبية الترجمة الآلية (GNMT)

معظمنا هي أكثر أو أقل استخدام الترجمة جوجل، فإنه من الضروري أن نتحدث عن تنفيذها GNMT جوجل في عام 2016. GNMT مثال على مزيج من الأولين (مثال الأول من وحي أساسا من ).

العلاقة بين وجود بقايا تكوين التشفير LSTM يتألف من 8، حيث أول ثنائية الاتجاه (والذي هو ناتج شلال)، طبقات متتالية (بدءا من الطبقة 3) الانتاج. فك LSTM ثمانية في اتجاه كومة مستقل.

سجل الوظائف باستخدام المضافات / CONCAT، و كما.

وبالمثل، و، والخطوة التالية من فك إدخال ناقلات سياق سلسلة بين الناتج من الخطوة السابقة مرة فك (الوردي) والوقت الحالي خطوة (الأخضر الداكن).

الشكل 2C: جوجل ترجمة NMT. وأشار اتصال الهيب بواسطة السهم المنحني. ملاحظة: وحدة LSTM تظهر الدولة الخفية والمدخلات، وسائل الإدخال لا يعرض الوضع

نموذج WMT'14 الإنجليزية - قيمة BLEU بلغ 38.95 في مجموعة البيانات الفرنسي، في WMT'14 الإنجليزية - قيمة BLEU بلغت 24.17 في مجموعة البيانات الألمانية.

GNMT: seq2seq مكدسة مع ثمانية الترميز (+ ثنائية + اتصال بقايا) + الاهتمام

8 الترجمة من A، B إلى H اصطف من أعلى إلى أسفل. وكل مترجم قراءة النص نفسه الألماني. لكل كلمة، المترجم A "حصة" اكتشاف وباء، وB لتحسين الترجمة و"حصة" وC - كرر هذه العملية حتى تصل الترجمة H. وبالإضافة إلى ذلك، عند قراءة النص الألماني، ستستند المترجمين H في سجلاته والمعلومات الواردة معرفة الكلمات الرئيسية ذات الصلة.

بعد الانتهاء من كل مترجم قراءة النص الألماني، وسوف تبدأ المترجمين مترجم الكلمة الأولى. أولا، دعم الذاكرة الأصلي، ثم الإجابات حصة مع B، B لتحسين إجابات وتقاسمها مع C - كرر هذه العملية حتى تصل الترجمة H. H إرسال مترجم يترجم الكلمة الأولى على أساس الكلمات الرئيسية والحصول على إجابات على سجله. كرر هذا حتى كل من الترجمة.

3. ملخص

توضح هذه المقالة الإطار التالي:

- seq2seqseq2seq + seq2seq اهتمام مع ثنائي الاتجاه اهتمام التشفير + seq2seq مع مزدوجة مكدسة الاهتمام التشفير + GNMT: seq2seq مكدسة مع ثمانية الترميز (+ ثنائية + اتصال بقايا) + الاهتمام

ملحق: وظيفة التهديف

وفيما يلي بعض من وظيفة تسجيل مكتوبة ليليان ونغ. مذكورة في هذه المقالة الادمان / CONCAT ونقطة المنتج. التفكير يتعلق دوت المنتج (دوت المنتج، الخ جيب التمام التشابه) وظيفة النتيجة هي مقياس لمدى التشابه بين متجهين. لfeedforward العصبية وظيفة الشبكة التهديف، والفكرة هي لجعل التعلم الأوزان محاذاة نموذج والترجمة.

FIG A0: ملخص التهديف وظيفة الرسم البياني

الشكل A1: ملخص التهديف وظيفة الصيغة

نقل: الشبكي: //zhuanlan.zhihu.com/p/56704058