الجهاز لا تعلم www.jqbxx.com: عمق تعلم الآلة البلمرة، خوارزميات التعلم عميقة والتقنيات القتالية

تم تطوير VGGNet مع جامعة أكسفورد الحاسوب فيجن جروب (مجموعة VisualGeometry) شركة وGoogleDeepMind الباحث عمق التفاف الشبكة العصبية. VGGNet استكشاف العلاقة بين عمق الشبكة العصبية التلافيف وأدائها، من خلال التراص مرارا صغيرة 3 * 3 التفاف النواة وطبقة أقصى الخلية 2 * 2، VGGNet بنجاح بناء طبقة عميقة من الإلتواء 16-19 الشبكة العصبية. مقارنة VGGNet سابقة للدولة من بين الفن والعمارة الشبكة، انخفض معدل خطأ كبير، وجعلت ILSVRC 2014 مشروع تصنيف السباق من أول واحد من المشروعين وتحديد المواقع. وفي الوقت نفسه توسيع VGGNet خطوة قوية لبيانات تعميمها على الصورة الأخرى هو جيد جدا. هيكل VGGNet بسيط جدا، تستخدم الشبكة بالكامل نفس حجم نواة الإلتواء من حجم (3 * 3) وحجم تجمع أقصى (2 * 2). حتى الآن، لا يزال VGGNet غالبا ما تستخدم لاستخراج ملامح الصورة. المعلمات نموذج التدريب VGGNet على مصدره مفتوحة الموقع الرسمي، ويمكن استخدامها لإعادة تدريب (أي ما يعادل توفير الأوزان التهيئة جيد جدا) على المهمة تصنيف صورة معينة، لذلك فإن استخدامها في الكثير من الأماكن.

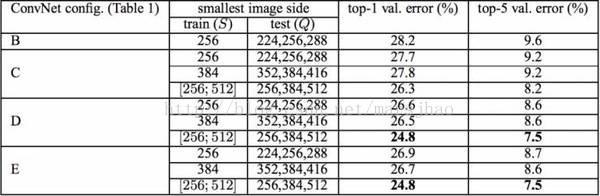

ورقة VGGNet عن استخدام 3 * 3 التفاف نواة وتجميع كور 2 * 2، من خلال تعميق بنية الشبكة لتحسين الأداء. كما هو مبين في الشكل. 1 هو تكوين شبكة الرسم VGGNet جميع المستويات، كما هو مبين في الشكل. 2 معلمة من قيمة كل المستويات، من طبقة الشبكة 11 تصل إلى طبقة الشبكة 19 مفصلة اختبارات الأداء. في حين تدريجيا أعمق من الألف إلى E كل شبكة، ولكن المبلغ من معلمات الشبكة ولا يزيد بكثير، لأن المعلمات الرئيسية هي الكمية المستهلكة في الطبقات الثلاث الماضية مرتبطة ارتباطا كاملا. في حين العميق أمام الجزء الإلتواء، ولكن ليس كمية المعلمات استهلاك، ولكن التدريب لا يزال جزء تستغرق وقتا طويلا نسبيا هو الإلتواء، بسبب كثافة حسابيا. هذا هو واحد من D، E هو، ونحن غالبا ما يقولون VGGNet-16 و VGGNet-19. C المثير للاهتمام جدا، بالمقارنة مع أكثر من التفاف عدة طبقات B 1 * 1 * 11 أهمية أساسا في أن تحول التفاف الخطي، وعدد من القنوات المدخلات وقنوات الانتاج دون تغيير، لا يحدث تخفيض البعد.

عندما التدريب، وصورة مدخلات RGB من حجم 224 * 224، فقط عن طريق طرح متوسط المعالجة كل RGB بكسل في مجموعة التدريب.

هيكل الشبكة FIG 1 VGGNet على جميع المستويات

كمية FIG 2 VGGNet على جميع المستويات من معلمات الشبكة

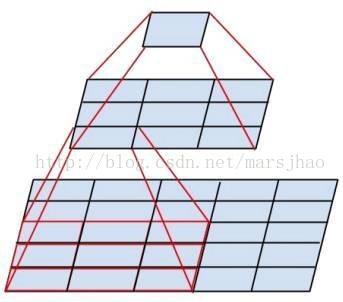

قسم VGGNet 5 لديه الإلتواء، والالتواء 2-3 طبقات في كل قسم، في حين أن ذيل كل قطعة يربط الحد الأقصى لحجم تجمع طبقة للحد من الصورة. حيث بلغ عدد التفاف حبات داخل كل قسم، وكلما زاد عدد من شريحة التفاف جوهر Echigo حسب: 64-128-256-512-512. بالضبط نفس الحالة التي أكثر من طبقة 3 * 3 التفاف مكدسة معا في كثير من الأحيان، وهذا هو في الواقع تصميم مفيدة جدا. 3، يمكن القول طبقتين من سلسلة يتوافق 3 * 3 التفاف إلى التفاف من 5 * 5 طبقات، أي، سوف بكسل والمرتبطة بكسل حوالي 5 * 5 حجم الحقل تقبلا هو 5 * 5. 3 و 3 * 3 طبقات التفاف إحداث سلسلة من الطبقات 7 * 7 الالتواء هو ما يعادلها. وبالإضافة إلى ذلك، طبقة ثلاثة جنبا إلى جنب 3 * 3 الإلتواء، مع نسبة 7 * 7 طبقات التلافيف كمية أصغر من المعلمات، إلا أن الأخير (3 * 3 * 3) / (7 * 7 ) = 55. الأهم من ذلك، طبقة التفاف 3 ديها نسبة 3 * 3 الإلتواء 7 * 7 طبقات من التحول غير الخطية (السابق يمكن استخدام مكعب ReLU وظيفة التنشيط، في حين أن هذا الأخير مرة واحدة فقط)، بحيث خصائص CNN قدرة أقوى على التعلم.

3 سلسلتين 3'3 ظيفة التفاف مماثلة طبقة التلافيف طبقة من 5'5

VGGNet ديهم قليل من المهارة في مجال التدريب، التدريب الأول مستوى شبكة بسيطة، ومن ثم إعادة إعادة تهيئة العديد من النماذج المعقدة مع الحق وراء شبكة من هذا التلاقي التدريب بشكل أسرع. عند التنبؤ، وذلك باستخدام أسلوب متعدد مقياس VGG، حجم الصورة إلى حجم Q، وصورة مدخلات الحوسبة شبكة التلافيف. ثم في تجسيد الأخير من طبقة نافذة انزلاق يستخدم تصنيف وتوقع التلافيف، ونتائج تصنيف مختلف متوسط النافذة، ثم وبلغ متوسط Q أحجام مختلفة لإعطاء النتيجة النهائية، التي يمكن أن تحسن الاستفادة من بيانات الصورة وتحسين دقة التنبؤ. في مجال التدريب، وتستخدم VGGNet متعدد مقياس أيضا لعملية تعزيز البيانات، يتم تحجيم الصورة الأصلية لمختلف الأحجام S، ثم قص عشوائيا 224'224 الصور، وهذا يمكن أن تزيد من عدد من كمية البيانات، لمنع الإفراط في تركيب نموذج هناك نتائج جيدة جدا. في الواقع، فإن قيمة الطلبات في S هذا الفاصل الزمني، واستخدام متعدد مقياس الحصول على إصدارات متعددة من البيانات وإصدارات متعددة من البيانات معا للتدريب. ويبين الشكل (4) والنتائج التي تم الحصول عليها عند استخدام التدريب VGGNet متعدد مقياس، D و E يمكن أن ينظر إلى أن نسبة الخطأ قد تصل إلى 7.5. يقدم النسخة النهائية لILSVRC 2014 لاستخدام فقط في شبكة D التكامل من ستة مستويات مختلفة من شبكة واحدة على نطاق ومتعدد مقياس، حيث بلغت نسبة الخطأ 7.3. ولكن بعد المباراة وجد الباحثون أن الوحيد الانصهار متعدد مقياس D و E يمكن أن تحقق نتائج أفضل، ونسبة الخطأ 7.0، ومن ثم استخدام استراتيجيات أخرى لتحسين نسبة الخطأ الأخير قد تصل إلى 6.8، وهو نفس العام بطولة هي قريبة جدا إلى Google Inceptin نت . وفي الوقت نفسه، خلص الباحثون إلى أن مستويات مقارنة من شبكة الاتصال التالية عدة آراء: لا تأثير طبقة (1) LRN (VGGNet دون استخدام استجابة موحدة جزئية (وLRN)، التي ليست موحدة وتحسين الأداء في مجموعة البيانات ILSVRC، ولكن مما يؤدي إلى مزيد من استهلاك الذاكرة والوقت الحوسبة)؛ (2) وأفضل تأثير شبكة أعمق، الإلتواء (3) 1 * 1 هو أيضا فعالة جدا، ولكن ليس جيدا 3 * 3 الالتواء، وعدد كبير من الإلتواء نواة يمكن معرفة المزيد من ميزة الغرفة.

FIG 4 VGGNet جميع المستويات عند استخدام التدريب نسبة الخطأ متعدد مقياس من أعلى 5

في عملية التدريب، ونسبة AlexNet التقارب ليكون أسرع، للأسباب التالية: (1) صغيرة نواة الالتواء وأعمق تنظيم الشبكة؛ (2) باستخدام بيانات السابقة لتدريب المعلمة التي تم الحصول عليها في طبقة محددة التهيئة.

لشبكة الضحلة، مثل شبكة A، ويمكن استخدام رقم عشوائي كما التهيئة عشوائية، وشبكة عميقة نسبيا، وذلك باستخدام المعلمة القيم شبكة الضحلة تدريب سابقا قبل طبقة طبقات التفاف لها طبقة الاتصال والتهيئة الكاملة الماضية.

عنوان ورقة: الشبكي: //arxiv.org/abs/1409.1556

نقل: الشبكي: //blog.csdn.net/marsjhao/article/details/72955935